本文为 Gemini 技术报告中文翻译。

- 原文档(PDF):Gemini: A Family Of Highly Capable Multimodal Models.pdf

- 英文网页版转载:Gemini: A Family Of Highly Capable Multimodal Models.html

相关文档:AlphaCode 2 技术报告中文翻译

Keywords:

Gemini: A Family Of Highly Capable Multimodal Models, Gemini, Google, paper, LLM, AI, fulltext, web, html, pdf, markdown, translation, translate, Chinese, multimodal, model

谷歌,双子座,技术报告,双子座: 一组功能强大的多模态模型,论文,全文,网页版,翻译,多模态,模型,中文,汉语

双子座团队,谷歌¹

本报告介绍了 Gemini,一组新型的多模态模型,在图像、音频、视频和文本理解方面展示了卓越能力。Gemini 系列包括三种不同规模的模型:Ultra、Pro 和 Nano,适应从复杂推理任务到内存受限的移动设备等多样化应用。广泛基准测试的评估结果表明,我们最先进的 Gemini Ultra 模型在 32 项测试中的 30 项上中取得了突破性进展,尤其值得注意的是,它是首个在广为研究的考试基准 MMLU 上达到人类专家水平的模型,并在我们检验的所有 20 项多模态基准测试中均刷新了最高技术水平。我们相信,Gemini 模型在跨模态推理和语言理解方面的新能力将开启广泛的应用场景,并在报告中讨论了我们负责任地向用户部署这些模型的策略。

1. 引言

我们推出了 Gemini,这是谷歌开发的一组功能强大的多模态模型。Gemini 通过联合训练,覆盖图像、音频、视频和文本数据,旨在构建一款跨模态具有强大通用能力并在各自领域展现卓越理解与推理性能的模型。

Gemini 1.0 是我们的首个版本,提供三种规模:Ultra 用于处理高度复杂的任务,Pro 在大规模部署中提供出色的性能和可部署性,而 Nano 则专为移动设备应用设计。每种规模都针对不同的计算限制和应用需求进行了精心定制。我们对 Gemini 模型进行了全面评估,涉及广泛的语言、编程、推理和多模态任务,既包括内部测试也包括外部基准。

Gemini 在多个领域推动了最前沿技术的发展,包括大规模语言建模(Anil 等,2023;Brown 等,2020;Chowdhery 等,2023;Hoffmann 等,2022;OpenAI,2023a;Radford 等,2019;Rae 等,2021)、图像理解(Alayrac 等,2022;Chen 等,2022;Dosovitskiy 等,2020;OpenAI,2023b;Reed 等,2022;Yu 等,2022a)、音频处理(Radford 等,2023;Zhang 等,2023)以及视频理解(Alayrac 等,2022;Chen 等,2023)。此外,Gemini 还基于序列模型(Sutskever 等,2014)、深度学习中基于神经网络的长期研究(LeCun 等,2015)以及支持大规模训练的机器学习分布式系统(Barham 等,2022;Bradbury 等,2018;Dean 等,2012)进行了构建和创新。

我们最强大的模型,Gemini Ultra,在 32 项基准测试中的 30 项上取得了最先进结果,包括在 12 项文本和推理测试中的 10 项、9 项图像理解测试中的全部、6 项视频理解测试中的全部以及 5 项语音识别与翻译测试中的全部。特别值得注意的是,Gemini Ultra 在 MMLU(Hendrycks 等人,2021a)考试基准测试中首次达到了人类专家的水平,其得分超过 90%(这是一个著名的基准测试,通过一系列考试测试知识和推理)。除了文本,Gemini Ultra 在具有挑战性的多模态推理任务上也取得了显着的进步。例如,在最新的 MMMU(Yue 等人,2023)基准测试中,Gemini Ultra 展现出对需要大学水平知识和深入推理的多学科图像问题的卓越处理能力,取得了 62.4% 的新高,较先前的最佳模型提高了超过 5 个百分点。Gemini Ultra 在视频问答和音频理解的基准测试中提供了统一而显著的性能提升,展现了其在多模态领域的前瞻性和创新能力。

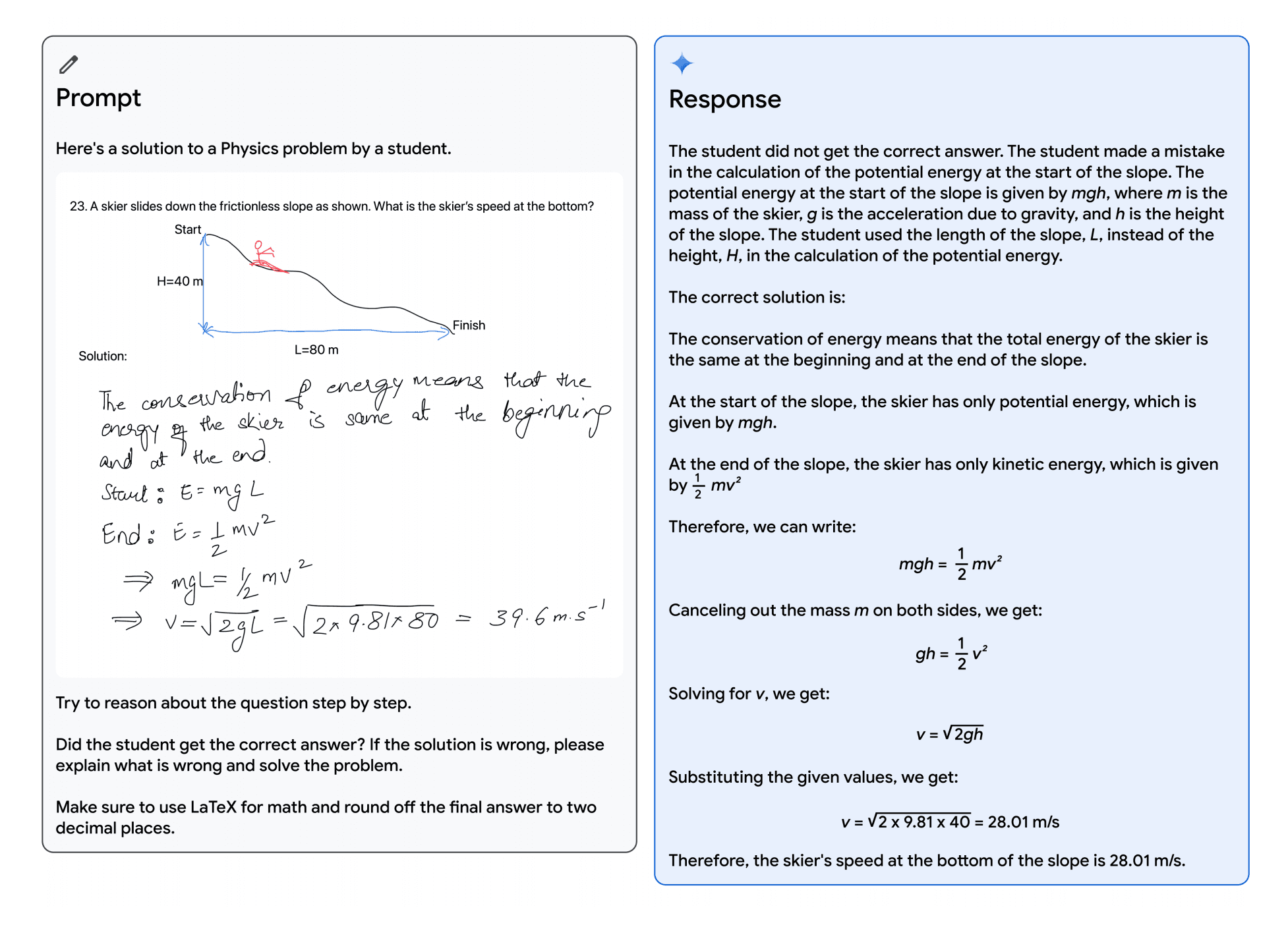

在定性评估中,Gemini 的卓越跨模态推理能力让它能够准确理解和推理音频、图像和文本输入序列的内容(详见图 5 和表 13)。以图 1 所描述的教育场景为例:一位教师在黑板上画出一个滑雪者下坡的物理问题,学生则提出了自己的解答。利用 Gemini 的多模态推理能力,模型能够解读复杂的手写内容,准确理解问题表述,将问题和解答转化为数学排版格式,识别出学生解题中的错误步骤,并提供正确的解答方法。这一能力为教育领域带来了新的可能性,我们相信 Gemini 模型在多模态推理和语言理解方面的新能力将广泛应用于多个领域。

图 1 | 验证学生解决物理问题的解答。该模型能够准确识别所有手写内容,并验证推理过程。除了理解图像中的文本,它还需要理解问题设置,并正确生成 LaTeX。

大型语言模型在处理复杂的多步骤问题上展现了巨大潜力。AlphaCode 团队开发了 AlphaCode 2(Leblond 等人,2023),这是一个新的由 Gemini 驱动的智能体,它结合了 Gemini 的推理能力、搜索功能和工具使用能力,擅长解决竞赛编程问题。AlphaCode 2 在 Codeforces 竞赛编程平台上的排名进入了前 15%,相比其前身(排名前 50%)有了显著的提升(Li 等人,2022)。

同时,我们在效率方面也取得了进展,推出了 Gemini Nano 系列,这是一系列小型模型,专门用于移动设备部署。这些模型在移动设备上的任务表现卓越,如摘要、阅读理解和文本完成任务,并且在推理、STEM、编程、多模态和多语言任务上相对于其体积展现出卓越的能力。

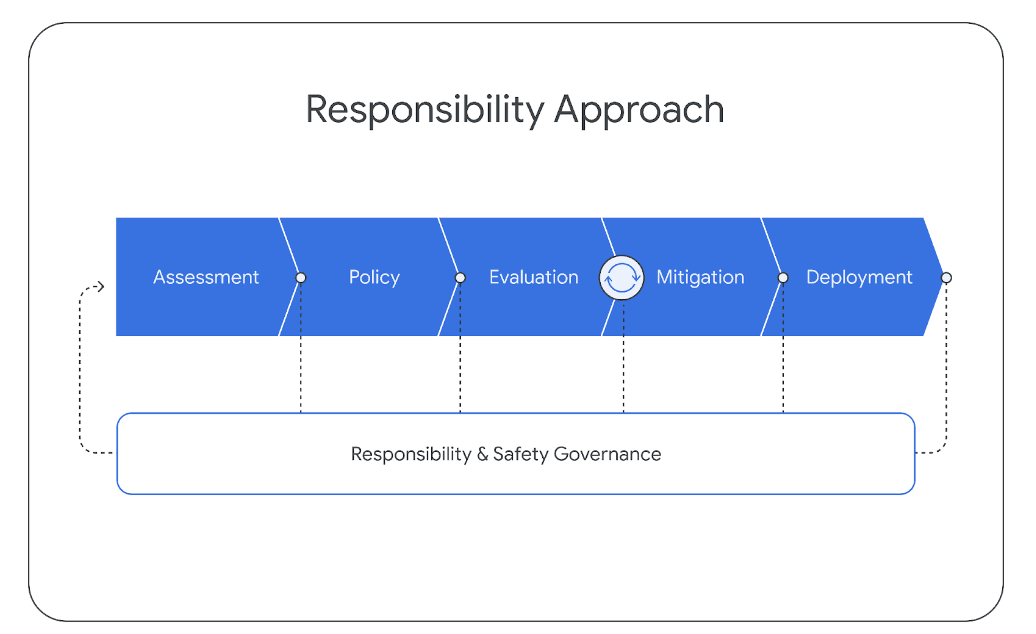

在后续章节中,我们将首先对模型架构、训练基础设施和训练数据集进行概览。接着,我们将深入介绍 Gemini 模型系列的详细评估,包括广泛的基准测试和人类偏好评估,覆盖文本、代码、图像、音频和视频等领域,同时考虑了英语性能和多语言能力。我们还将讨论我们的负责任部署策略,² 其中包括影响评估的过程、制定模型政策、评估方法以及在部署决策前进行的危害缓解措施。最后,我们将探讨 Gemini 在更广阔领域的影响、潜在应用,以及它的局限性,为 AI 研究和创新的新时代铺平了道路。

2. 模型架构

Gemini 模型基于 Transformer 解码器(Vaswani 等,2017)构建,通过架构和模型优化改进实现了大规模的稳定训练和在 Google 的 Tensor Processing Units 上的高效推理。这些模型支持长达 32k 个上下文长度,采用了高效的注意力机制,例如多查询注意力(Shazeer,2019)。我们的首版 Gemini 1.0 提供了三种主要规模,以适应广泛的应用需求,如表 1 所示。

| 模型大小 | 模型描述 |

|---|---|

| Ultra | 我们最强大的模型,可在包括推理和多模态任务在内的一系列高复杂度任务中提供顶尖性能。得益于 Gemini 架构,它能在 TPU 加速器上高效运行。 |

| Pro | 这款模型在成本和延迟方面进行了优化,能够在广泛的任务中提供显著性能。它展现了出色的推理能力和广泛的多模态能力。 |

| Nano | 我们最高效的模型,专门设计用于移动设备。我们推出了两个版本的 Nano,分别拥有 1.8B(Nano-1)和 3.25B(Nano-2)参数,适用于不同内存容量的设备。通过从更大的 Gemini 模型中蒸馏得来,实现了 4 位量化以便部署,并在同类产品中提供了最佳性能。 |

表 1 | Gemini 1.0 模型系列概览。

Gemini 模型经过训练,能够处理交错的文本、音频和视觉输入,比如自然图像、图表、截图、PDF 和视频,并能生成文本和图像输出(见图 2)。Gemini 的视觉编码灵感来自我们在 Flamingo(Alayrac 等人,2022)、CoCa(Yu 等人,2022a)和 PaLI(Chen 等人,2022)上的基础性工作,其独特之处在于,这些模型从一开始就被设计为多模态,并能使用离散图像标记(Ramesh 等人,2021;Yu 等人,2022b)直接输出图像。

图 2 | Gemini 支持交错的文本、图像、音频和视频输入序列(输入序列中不同颜色的标记代表不同的模态)。它能够输出包含交错图像和文本的响应。

Gemini 模型通过将视频编码成大型上下文窗口中的帧序列来实现视频理解。视频帧或图像可以自然地与文本或音频交错,成为模型输入的一部分。模型能够处理不同的输入分辨率,使其能够在需要细致理解的任务上投入更多计算资源。此外,Gemini 还能直接处理来自 Universal Speech Model (USM)(Zhang 等人,2023)的 16kHz 音频信号,捕捉到在将音频简单转换为文本时通常会丢失的细节(例如,可参见网站上的音频理解演示)。

开发 Gemini 系列模型需要在训练算法、数据集和基础设施上进行创新。对于 Pro 模型,我们的基础设施的可扩展性和先进的学习算法使得我们能够在几周内完成预训练,且使用的资源只是 Ultra 的一小部分。Nano 系列模型则利用了在模型蒸馏和训练算法方面的额外进展,生产出了同类中最优的小型语言模型,适用于诸如摘要和阅读理解等多种任务,为我们下一代移动设备体验提供了强大动力。

3. 训练基础设施

我们利用 TPUv5e 和 TPUv4(Jouppi 等人,2023)训练了 Gemini 模型,具体取决于模型的规模和配置。训练 Gemini Ultra 时,我们在多个数据中心部署了大量 TPUv4 加速器。与我们之前的旗舰模型 PaLM-2 相比,这一规模的显著增加带来了新的基础设施挑战。增加加速器数量会导致整个系统中硬件故障间隔时间成比例地缩短。我们尽可能减少了计划内的重新安排和预防性维护,但在如此大规模的硬件加速器中,真实的机器故障(如因外部因素,例如宇宙射线(Michalak 等人,2012)造成的)仍然普遍存在。

TPUv4 加速器被部署在包含 4096 个芯片的“SuperPods”中,每个都连接到专用的光学开关,能够在约 10 秒内将 4x4x4 芯片立方体动态重组为任意的 3D 环形拓扑。在 Gemini Ultra 的部署中,我们选择在每个 superpod 中保留少量立方体,以便于进行热备份和滚动维护。

TPU 加速器主要通过高速的芯片间互连进行通信,但在 Gemini Ultra 的规模上,我们通过谷歌的集群内和集群间网络(Poutievski 等人,2022;Wetherall 等人,2023;yao Hong 等人,2018)将多个数据中心的 SuperPods 结合使用。谷歌的网络延迟和带宽足以支持常见的同步训练范式,实现 superpods 内的模型并行性和 superpods 间的数据并行性。

Jax(Bradbury 等人,2018)和 Pathways(Barham 等人,2022)的“单控制器”编程模型允许单个 Python 进程协调整个训练过程,极大地简化了开发流程。XLA 编译器中的 GSPMD 分区器(Xu 等人,2021)用于分区训练步骤的计算,而 MegaScale XLA 编译器(XLA,2019)则通过静态安排合适的集合操作,使其与计算最大程度重叠,使步骤时间变化最小化。

在这种规模下,使用传统的定期检查点方法将权重保存到持久化集群存储中无法维持高 goodput³。对于 Gemini,我们改为使用模型状态的冗余内存副本,并在任何意外硬件故障时直接从完整的模型副本中快速恢复。与 PaLM 和 PaLM-2(Anil 等人,2023)相比,尽管使用了更大的训练资源,这一方法在恢复时间上实现了显著的加速。因此,最大规模训练作业的整体 goodput 从 85% 提升到了 97%。

在史无前例的规模下进行训练不可避免地会揭示新的和有趣的系统故障模式 - 在这种情况下,我们面临的一个挑战是“无声数据损坏 (SDC)”(Dixit 等人,2021;Hochschild 等人,2021;Vishwanathan 等人,2015)。尽管这些事件非常罕见,但鉴于 Gemini 的庞大规模,我们可以预计 SDC 事件将每周或每两周影响一次训练。为了迅速检测和排除故障硬件,我们采用了多种新技术,这些技术结合了确定性重放来隔离错误计算,以及在闲置机器和热备机器上进行的主动 SDC 扫描。我们完全确定性的基础设施使我们能够在开发过程中迅速识别根本原因(包括硬件故障),这对于实现稳定训练至关重要。

4. 训练数据集

Gemini 模型在一个包含多模态和多语言的数据集上进行训练。我们的预训练数据集包括了来自网页文档、书籍和代码的数据,以及图像、音频和视频数据。

我们使用 SentencePiece 分词器(Kudo 和 Richardson,2018)进行训练,发现在整个训练语料库的大样本上训练分词器可以改善推断出的词汇表,进而提高模型性能。例如,我们注意到 Gemini 模型能够高效地标记化非拉丁字符,这反过来又提高了模型质量以及训练和推理的速度。

我们训练最大模型时使用的标记数量是依照 Hoffmann 等人 (2022) 的方法确定的。相对于大模型,我们对较小的模型进行了更多标记的训练,以在给定推理预算下提升性能,这与 Touvron 等人 (2023a) 的建议相一致。

对于所有数据集,我们应用了质量过滤器,结合启发式规则和基于模型的分类器。此外,我们还进行了安全过滤,以排除有害内容。我们的评估集是从训练语料库中筛选出来的。最终的数据混合和权重是通过在较小模型上进行消融实验确定的。我们分阶段调整训练,以改变数据组合——在训练后期增加与特定领域相关数据的比重。我们认为,数据质量对于实现高性能模型至关重要,而在确定预训练的最优数据集分布方面还有许多值得探索的问题。

5. 评估

Gemini 模型由于在文本、图像、音频和视频上进行了联合训练,因此具有原生多模态特性。一个关键问题是,这种联合训练是否能够产生在各个域都表现出强大能力的模型——即便与专门针对单一域的模型和方法相比。我们的发现是肯定的:Gemini 在各种文本、图像、音频和视频的基准测试中均刷新了最高技术水平。

5.1. 文本

5.1.1. 学术基准

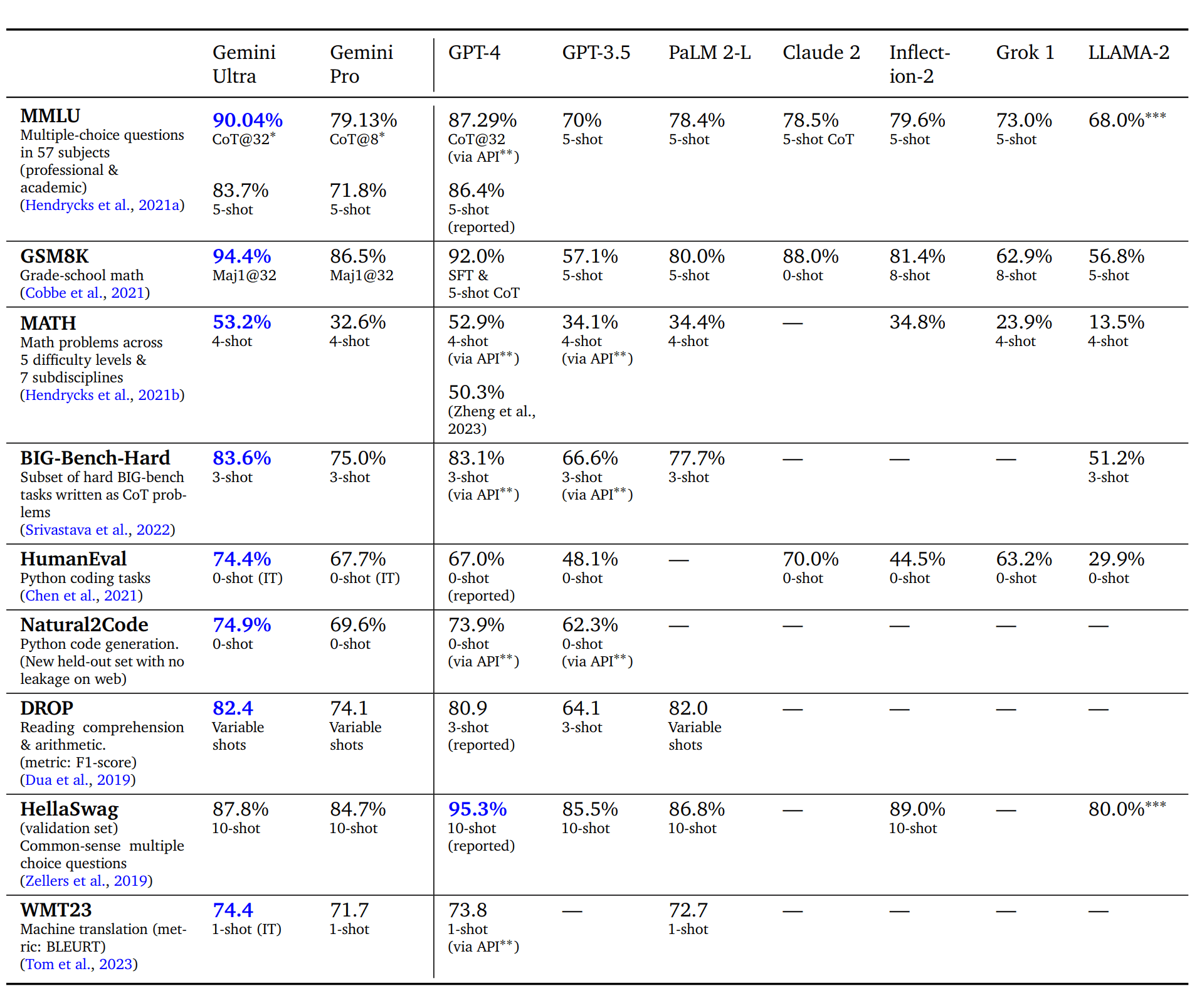

我们比较了 Gemini Pro 和 Ultra 与一系列外部的大型语言模型(LLMs)以及我们之前的顶级模型 PaLM 2 在多个以文本为基础的学术基准上的表现,并在表 2 中汇报了这些结果。总体来看,我们发现 Gemini Pro 的性能优于诸如 GPT-3.5 这类面向推理优化的模型,并能与市场上最强大的模型媲美,而 Gemini Ultra 则超越了所有当前模型。下面,我们将探讨这些发现的一些细节。

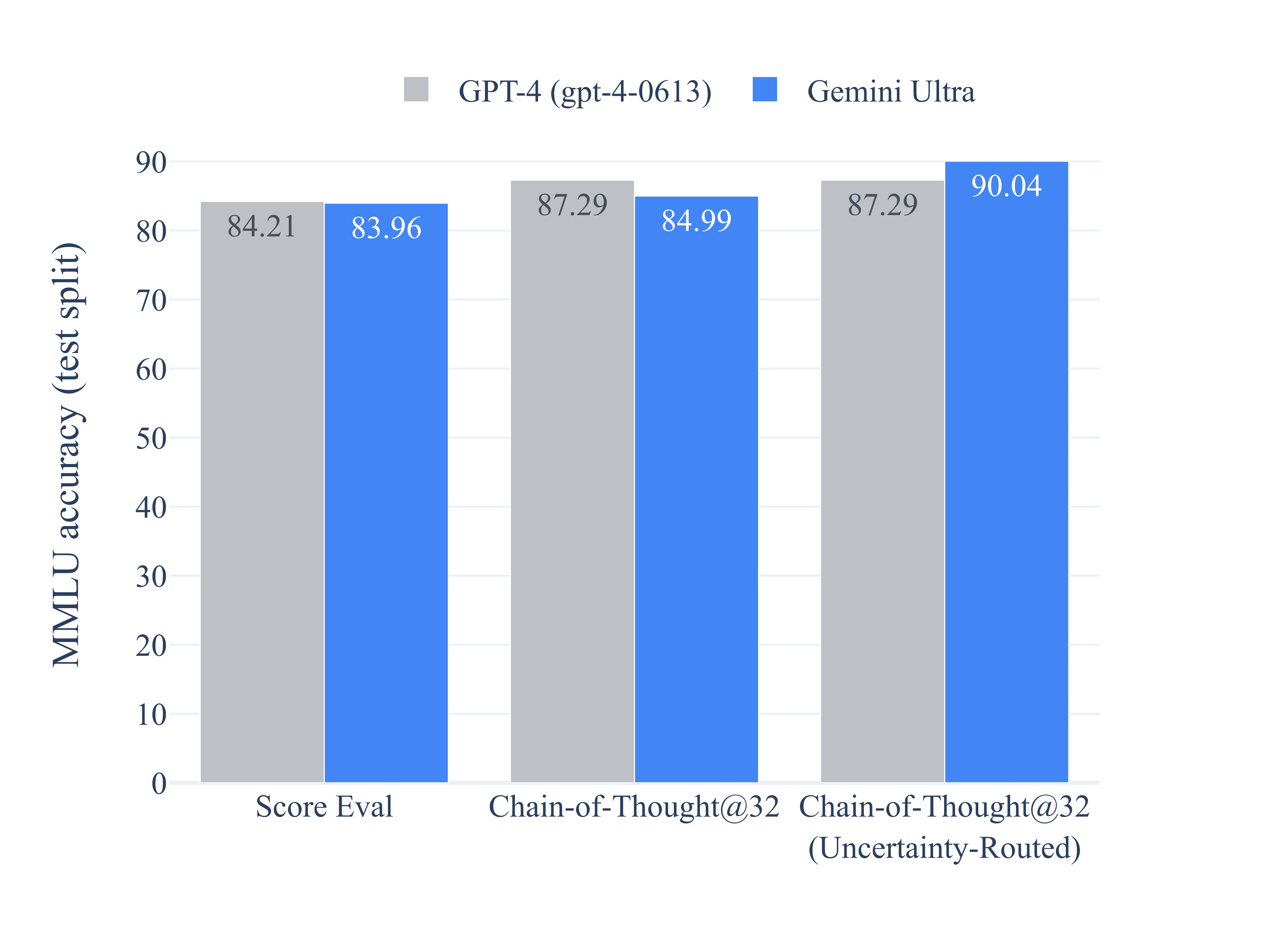

在 MMLU(Hendrycks 等人,2021a)上,Gemini Ultra 超越了所有现有模型,达到了 90.04% 的准确率。MMLU 是一个全面的考试基准,覆盖了 57 个科目的知识测试。基准的作者将人类专家的表现估计为 89.8%,而 Gemini Ultra 是首个超过此阈值的模型,之前的最高水平为 86.4%。要实现高性能,需要在多个领域(如法律、生物学、历史等)具备专业知识,并具备良好的阅读理解和推理能力。我们发现,当使用思维链提示方法(Wei 等人,2022)时,Gemini Ultra 的准确率最高。该模型生成了 k 个样本的思维链,例如 8 个或 32 个。如果存在高于预设阈值的一致性,就会选择这个答案,否则它会回退到基于最大可能性选择的贪心样本,而不使用思维链。我们建议读者查阅附录,了解该方法与仅使用思维链提示或仅使用贪婪采样的比较。

在数学领域,通常用于检验模型的分析能力,Gemini Ultra 展现了其在初等和竞赛级数学问题上的强大性能。在 GSM8K(Cobbe 等人,2021)这个小学数学基准测试中,我们发现通过使用思维链提示和自洽性方法(Wang 等人,2022),Gemini Ultra 达到了 94.4% 的准确率,超过了此前使用相同技术达到的 92% 的最佳准确率。在更具挑战性的中学和高中数学竞赛问题(MATH 基准)上,Gemini Ultra 使用 4 次示例提示,表现超越了所有竞争对手,达到了 53.2%。在更难的任务上,如来自美国数学竞赛的问题(2022 年和 2023 年的 150 个问题),较小的模型表现接近随机,但 Gemini Ultra 能够解决其中的 32% 问题,相比 GPT-4 的 30% 解题率表现更佳。

Gemini Ultra 在编程领域也有出色表现,这是目前大型语言模型的一个热门应用场景。我们评估了它在多个传统和内部基准测试上的性能,并测量了它作为更复杂推理系统的一部分的表现,如第 5.1.7 节所述。例如,在 HumanEval 上,这是一个标准的将函数描述映射到 Python 实现的代码完成基准(Chen 等人,2021),经过指令调整的 Gemini Ultra 正确完成了 74.4% 的问题。在一个新的、排除网络泄漏的保留评估基准 Natural2Code 上,用于 Python 代码生成任务,Gemini Ultra 达到了最高的 74.9% 的分数。

表 2 | Gemini 在文本基准测试中的表现,与外部及 PaLM 2-L 比较。

∗ 该模型生成了 k = 8 或 32 个样本的思维链。如果存在高于预设阈值(基于验证集选择)的一致性,模型会选择这个答案;否则,它会采用基于最大可能性选择的贪心样本。有关此方法与仅使用思维链提示或仅使用贪婪采样的比较,可参见附录 9.1。

∗∗ 2023 年 11 月通过 API 自行收集的结果。

∗∗∗ 展示的结果使用了 Touvron 等人(2023b)报告中去除数据污染后的数字,作为与同样进行了去污染处理的 Gemini 模型的最相关比较。

评估这些基准测试具有挑战性,并且可能受到数据污染的影响。我们在训练后进行了广泛的泄露数据分析,以确保我们在此处报告的结果尽可能科学可靠,但仍然发现了一些小问题,因此决定不报告例如 LAMBADA(Paperno 等人,2016)的结果。在评估过程中,对流行的 HellaSwag 基准测试(Zellers 等人,2019),我们发现在特定网站摘录上额外进行一百步微调(这些摘录与 HellaSwag 训练集相对应,但未包含在 Gemini 预训练集中)可以将 Gemini Pro 的验证准确率提高到 89.6%,Gemini Ultra 提高到 96.0%,当使用一次示例提示时测量(我们测量了通过 API 评估的 GPT-4 获得的 92.3%)。这表明基准测试结果容易受到预训练数据集组成的影响。因此,我们选择仅在 10 次示例评估设置中报告 HellaSwag 的去污染结果。我们认为,需要更加健壮和细致的标准化评估基准,没有泄露数据。因此,我们在一些最近发布的新保留评估数据集上评估 Gemini 模型,例如 WMT23 和 Math-AMC 2022-2023 问题,或从非网络来源内部生成的 Natural2Code。我们建议读者查阅附录,以了解我们评估基准的全面列表。

尽管如此,模型在这些基准测试中的表现还是为我们提供了关于其能力的重要指示,以及它们可能在现实世界任务中的潜在影响。例如,Gemini Ultra 在推理和 STEM 领域的杰出表现为大型语言模型在教育领域的应用带来了新的前景。它处理复杂的数学和科学概念的能力,为个性化学习和智能辅导系统的发展开辟了新路径。

5.1.2. 能力趋势

我们通过在超过 50 个基准测试中的综合评估工具上评估 Gemini 模型系列,研究了其能力趋势,其中一些最重要的基准已在前文中讨论。这些能力包括:“事实性”,涵盖开放/封闭书籍检索和问答任务;“长上下文”,包括长篇摘要、检索和问答任务;“数学/科学”,涵盖数学问题解决、定理证明和科学考试等任务;需要算术、科学和常识推理的“推理”任务;以及“多语言”任务,用于多语言翻译、摘要和推理。详细的任务列表请参阅附录。

图 3 | Gemini 模型家族在不同能力方面的语言理解和生成性能,性能表现以 Gemini Pro 模型为基准进行归一化处理。

在图 3 中,我们可以看到随着模型规模的增大,在推理、数学/科学、摘要和长上下文等方面的性能显著提高。Gemini Ultra 在所有六种能力中均表现最佳。Gemini Pro 作为 Gemini 模型家族中的第二大模型,虽然规模较小,但在竞争力和效率方面也表现出色。

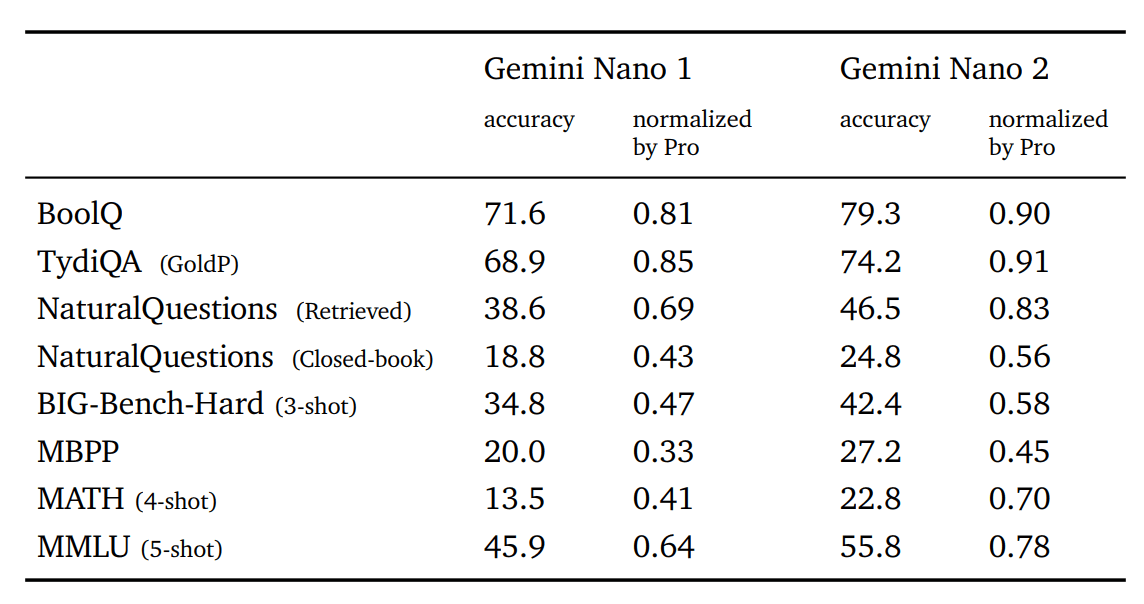

5.1.3. Nano

为了让 AI 更贴近用户,我们重点介绍了专为移动设备部署设计的 Gemini Nano 1 和 Nano 2 模型。这些模型在摘要和阅读理解任务上表现卓越,能够针对每项任务进行微调。图 3 展示了这些预训练模型与体型更大的 Gemini Pro 模型在性能上的对比,而表 3 则深入分析了在具体的事实性、编程、数学/科学和推理任务上的表现。Nano-1 和 Nano-2 模型的规模分别为 1.8B 和 3.25B 参数。尽管规模较小,它们在事实性即检索相关任务上展现了出色的性能,并在推理、STEM、编程、多模态和多语言任务中也显示了显著的表现。随着新功能的引入,Gemini 模型能够在更广泛的平台和设备上被访问,为所有用户提供更广泛的可访问性。

表 3 | 相比于更大的 Gemini Pro 模型,Gemini Nano 系列在事实性、摘要、推理、编码和 STEM 任务上的表现。

5.1.4. 多语言能力

我们通过一系列任务评估了 Gemini 模型的多语言能力,这些任务要求模型具备多语言理解、跨语言泛化和生成多种语言文本的能力。这包括机器翻译基准(WMT 23 中的高、中、低资源翻译;Flores 和 NTREX 针对低资源和非常低资源语言),摘要基准(XLSum 和 Wikilingua),以及一些常见基准的翻译版本(MGSM:专业翻译成 11 种语言)。

机器翻译

翻译是机器学习领域的经典基准之一,拥有悠久的历史。我们在 WMT 23 翻译基准中的所有语言对集合上评估了经过指令调整的 Gemini Ultra(请参阅第 6.4.2 节),并采用了少量示例设置。总体来看,我们发现 Gemini Ultra(以及其他 Gemini 模型)在将英语翻译成其他语言方面表现突出,并且在翻译高资源、中资源和低资源语言时超过了基于 LLM 的翻译方法。在 WMT 23 的从英语到外语翻译任务中,Gemini Ultra 达到了 LLM 翻译中最高的质量,平均 BLEURT(Sellam 等人,2020)得分为 74.8,而 GPT-4 的得分为 73.6,PaLM 2 的得分为 72.2。在 WMT 23 的所有语言对和方向的平均得分中,我们看到了类似的趋势,Gemini Ultra 为 74.4,GPT-4 为 73.8,PaLM 2-L 为 72.7。

表 4 | Gemini 模型在 WMT 23 翻译基准测试中的表现。所有结果均基于 1 次示例评估。

除了上述语言和翻译任务之外,我们还对 Gemini Ultra 在极低资源语言上的表现进行了评估。这些语言选自以下语言集的尾部样本:Flores-200(包括 Tamazight 和 Kanure),NTREX(包括 North Ndebele),以及一个内部基准(Quechua)。在这些语言上,无论是将英语翻译为其他语言还是将这些语言翻译为英语,Gemini Ultra 在 1 次示例设置中平均 chrF 分数为 27.0,而排名第二的模型 PaLM 2-L 的分数为 25.3。

多语言数学和摘要

除了翻译之外,我们还评估了 Gemini 在不同语言中处理具有挑战性的任务的能力。我们特别关注了 MGSM(Shi 等人,2023),这是 GSM8K(Cobbe 等人,2021)数学基准的翻译版本。在 8 次示例设置中,Gemini Ultra 的平均准确率达到了 79.0%,超过了 PaLM 2-L 的 74.7%,这是在所有语言中的平均表现。我们还在多语言摘要基准测试中对 Gemini 进行了评估,包括 XLSum(Hasan 等人,2021)和 WikiLingua(Ladhak 等人,2020)。在 XLSum 中,Gemini Ultra 的平均 rougeL 分数为 17.6,而 PaLM 2 为 15.4。在 WikiLingua 中,Gemini Ultra(5 次示例)在 BLEURT 分数上略低于 PaLM 2(3 次示例)。有关完整结果,请参见表 5。总体来看,多语言基准的多样性表明,Gemini 系列模型具有广泛的语言覆盖能力,使其能够触及使用低资源语言的地区和区域。

表 5 | Gemini 模型在多语言数学和摘要任务上的表现。

5.1.5. 长上下文

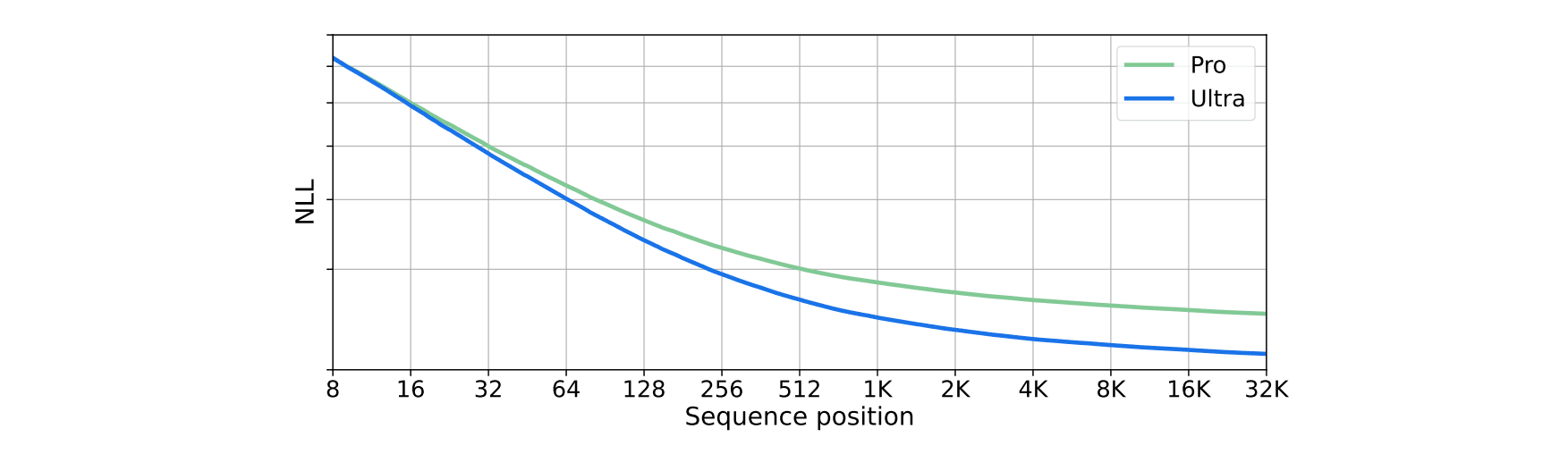

Gemini 模型训练时的序列长度达到了 32,768 个标记,我们观察到它们有效地利用了这一长上下文。我们首先通过执行一个合成检索测试来验证这一点:我们将键值对放置在上下文的开始部分,然后添加长文本,并询问与特定键相关的值。我们发现,Ultra 模型在整个 32K 上下文长度内以 98% 的准确率检索到正确值。我们进一步通过在一组保留长文档上绘制负对数似然(NLL)与令牌索引的关系图来探究这一现象。我们发现,NLL 随着序列位置的增加而降低,直到达到完整的 32K 上下文长度。Gemini 模型的更长上下文长度使得诸如文档和视频理解等新的应用场景成为可能,正如第 5.2.2 节所讨论的那样。

图 4 | 在一组保留的长文档上,负对数似然随着 32K 上下文长度内令牌索引的变化而变化的图表。

5.1.6. 人类偏好评估

模型输出的人类偏好是补充自动评估的重要质量指标。我们在盲测试中评估了 Gemini 模型,其中人类评审员对两个模型对同一提示的响应进行比较。我们使用在第 6.4.2 节讨论的技术对预训练模型进行了指令调整。经过指令调整的模型在一系列特定能力上进行了评估,包括遵循指令、创造性写作、多模态理解、长上下文理解和安全性。这些能力覆盖了当前用户需求和潜在未来用例的范围。

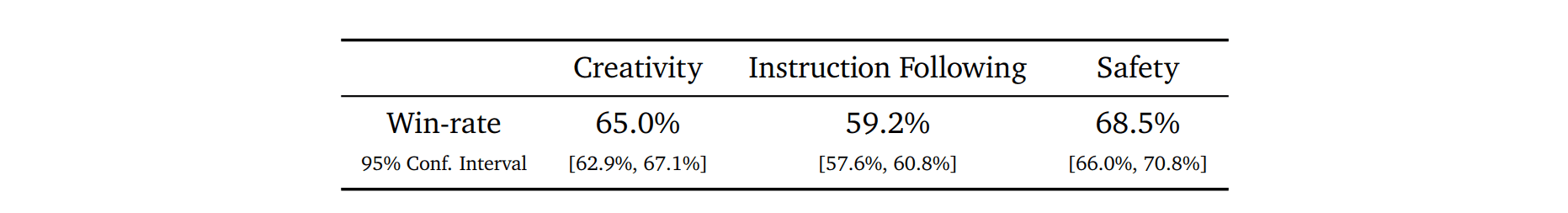

指令调整后的 Gemini Pro 模型在多个能力方面显示了显著的提升,包括在创造性写作中选择 Gemini Pro 超过 PaLM 2 的比例达到 65.0%,在遵循指令方面为 59.2%,在更安全响应方面为 68.5%,如表 6 所示。这些改进直接转化为更实用和更安全的用户体验。

表 6 | Gemini Pro 与 PaLM 2 (text-bison@001) 在创造性写作、遵循指令、多模态理解、长上下文理解和安全性方面的胜率对比,附有 95% 置信区间。

5.1.7. 复杂推理系统

Gemini 可以与其他技术如搜索和工具使用相结合,创建出能够解决更复杂、多步骤问题的强大推理系统。AlphaCode 2 就是这样一个例子,它是一个新的、达到最先进水平的智能智能体,专长于解决竞赛级编程问题(Leblond 等人,2023)。AlphaCode 2 使用了一种特殊版本的 Gemini Pro,该版本针对与 Li 等人(2022)中使用的竞赛编程数据类似的数据进行了调整,以在可能的程序空间中进行大规模搜索。随后是一个定制的过滤、聚类和重排序机制。Gemini Pro 被微调为编码模型,用于生成提议的解决方案候选,并作为奖励模型来识别和挑选最有前途的代码候选项。

AlphaCode 2 在 Codeforces⁵ 这个平台上进行了评估,与 AlphaCode 使用的是同一个平台,共进行了 12 场比赛,涵盖了一、二部门的共 77 个问题。AlphaCode 2 解决了这些竞赛问题中的 43%,相比之前创纪录的 AlphaCode 系统解决 25% 的问题有了 1.7 倍的提升。将这一成绩映射到比赛排名上,基于 Gemini Pro 的 AlphaCode 2 在平均水平上处于前 85% 的位置——即它的表现优于 85% 的参赛者。这比 AlphaCode 仅优于 50% 的竞争者有显著提升。

结合强大的预训练模型、搜索和推理机制,这一方向对于开发更通用智能体来说极具潜力;另一个关键要素是跨多种模态的深入理解,我们将在下一节中进行讨论。

5.2. 多模态

Gemini 模型具有原生多模态特性。这些模型展现出了独特的能力,能够无缝地融合跨模态能力(如从表格、图表或图形中提取信息和布局)和语言模型的强大推理能力(例如在数学和编码领域的领先水平),如图 5 和 12 所示。此外,模型还在识别输入的细节、整合空间和时间上下文信息以及在时间相关的视频帧序列和/或音频输入上应用这些能力方面表现出色。

以下部分将提供模型在不同模态(图像、视频和音频)上的更详细评估,以及模型在图像生成和跨模态信息组合方面的定性示例。

5.2.1. 图像理解

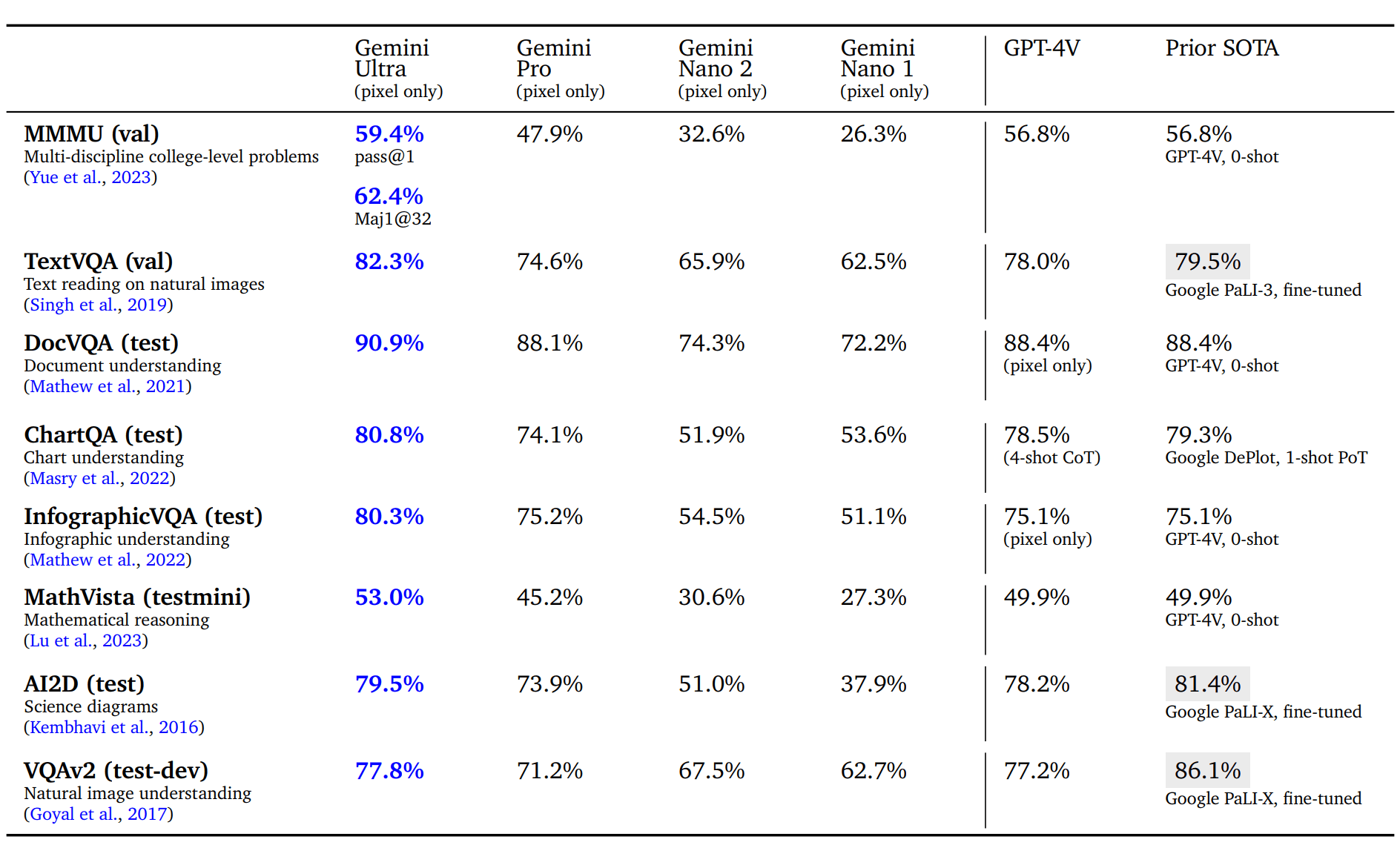

我们对模型在四个不同能力上进行了评估:使用标题或问答任务(如 VQAv2)进行高级别对象识别;使用任务(如 TextVQA 和 DocVQA)进行细致转录,要求模型识别低级别细节;使用任务(如 ChartQA 和 InfographicVQA)进行图表理解,需要理解输入布局的空间关系;以及使用任务(如 Ai2D、MathVista 和 MMMU)进行多模态推理。在零示例 QA 评估中,模型被指导提供与特定基准相符的简短答案。所有结果均通过贪婪采样获得,且没有使用任何外部 OCR 工具。

表 7 | 图像理解能力。即使在零示例学习条件下,尤其是在处理自然图像、文本、文档和图表中的 OCR(光学字符识别)相关任务时,Gemini Ultra 显著优于现有技术,且完全不依赖任何外部 OCR 引擎,仅使用像素数据。需要指出的是,许多现有方法会针对特定任务进行微调(如表中灰色部分所示),这导致直接将其与零示例学习进行比较并不公平。

我们发现,Gemini Ultra 在广泛的图像理解基准测试中都最为先进,如表 7 所示。它在各种任务上都取得了强大的表现,比如在自然图像和扫描文档上回答问题,以及理解信息图表、图表和科学图解。与其他模型(特别是 GPT-4V)的公开报告结果相比,Gemini 在零示例评估中表现更加出色。它还超越了许多专门在各自基准训练集上进行微调的现有模型。Gemini 模型的能力在学术基准上带来了显著的改进,如在 MathVista (+3.1%)⁶ 和 InfographicVQA (+5.2%) 等领域。

MMMU(Yue 等人,2023)是一个近期发布的评估基准,包含了一系列关于图像的问题,覆盖了 6 个学科领域,每个领域包含多个主题,解决这些问题需要大学级别的知识和复杂的推理能力。Gemini Ultra 在这一基准测试中表现卓越,将最先进的成绩提高了超过 5 个百分点,并在 6 个学科中的 5 个学科上超越了之前的最佳模型,展示了其多模态推理的强大能力。

表 8 | Gemini Ultra 在 MMMU 基准测试(Yue 等人,2023)中各学科的表现。每个学科涵盖多个主题,需要大学级别的知识和复杂推理。

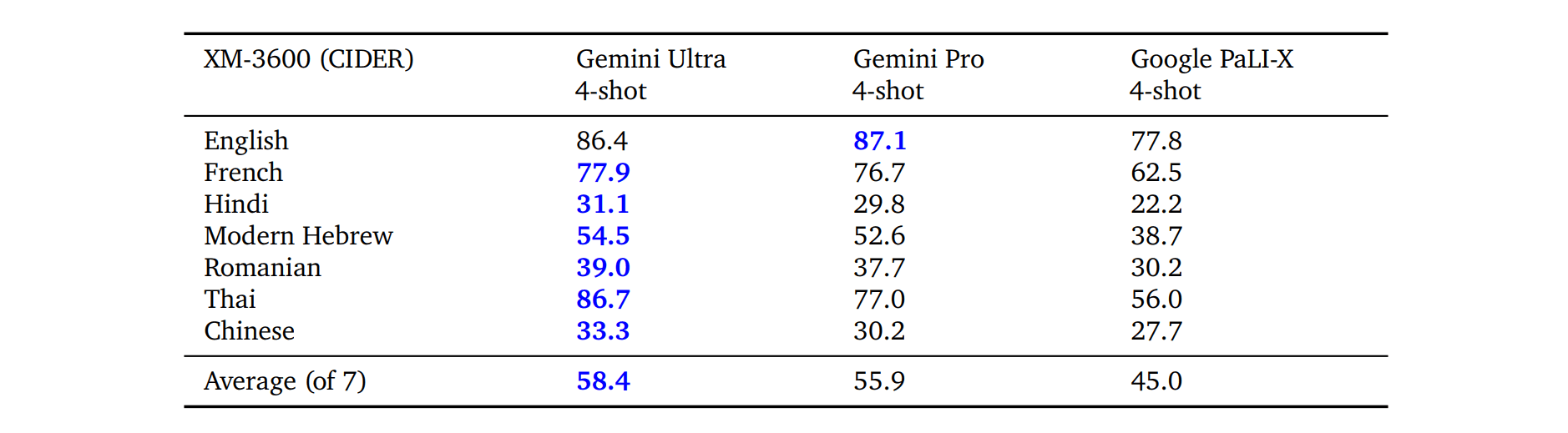

Gemini 模型同样能够同时在多种模态和广泛的全球语言环境中运作,不论是在理解任务(如包含冰岛文本的图像)还是在生成任务(如为多种语言生成图像描述)中。我们在跨模态 3600(XM-3600)基准的部分语言上评估了 Gemini 模型生成图像描述的性能,采用了 4 次示例设置,并遵循了 Flamingo 的评估协议(Alayrac 等人,2022),所有模型均未进行特定微调。正如表 9 所示,Gemini 模型在 XM-3600 数据集(Thapliyal 等人,2022)中选取的语言子集上字幕图像的表现显著优于现有的最佳模型,Google PaLI-X。

表 9 | 多语种图像理解能力。在 XM-3600 数据集(Thapliyal 等,2022)中所选取的多种语言子集上进行评估时,Gemini 模型在为图像添加多语言描述的能力上胜过了现有的模型。

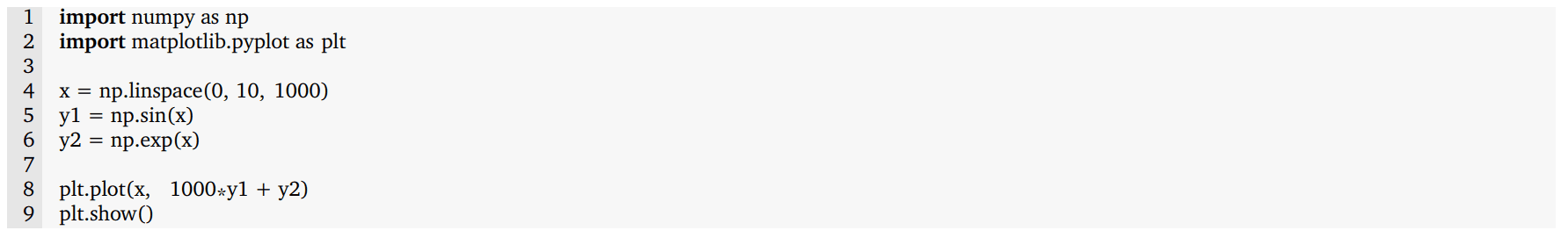

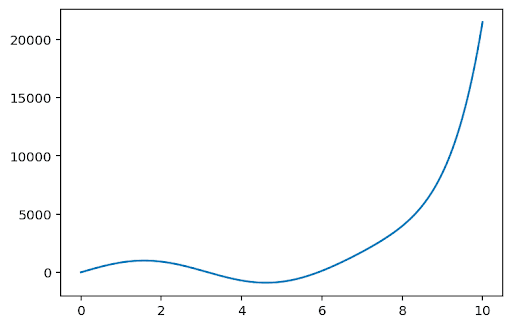

图 5 | Gemini 展示其多模态推理能力,生成 matplotlib 代码以重新排列子图。多模态提示显示在左上角的灰色区域。Gemini Ultra 的响应,包括其生成的代码,显示在右侧的蓝色区域中。左下方的图显示了生成代码的渲染效果。成功完成这个任务展示了模型的多种能力:(1)识别图中描绘的函数;(2)逆向图形学,推断出生成子图的代码;(3)按照指令将子图放置在指定位置;以及(4)进行抽象推理,判断指数图必须保持原位,因为正弦图需要为三维图让出空间。

定性评估在图 5 中展示了 Gemini Ultra 的多模态推理能力的一个示例。该任务要求模型生成 matplotlib 代码,以重新排列用户提供的一系列子图。模型的输出显示了它成功地完成了这个任务,融合了多种能力:理解用户图表、推断生成子图所需的代码、根据用户指示将子图放置在适当位置,以及对输出图表进行抽象推理。这不仅凸显了 Gemini Ultra 的原生多模态特性,还暗示了它在图像和文本序列间更复杂的推理能力。我们建议读者参阅附录以了解更多定性示例。

5.2.2. 视频理解

理解视频输入对于构建实用的通用智能体至关重要。我们建立了多个排除在训练集外的基准来衡量视频理解能力。这些任务旨在评估模型是否能够理解和推理一连串时间相关的帧。对于每项视频任务,我们从每个视频剪辑中抽取 16 帧等间隔帧,输入至 Gemini 模型。对于 YouTube 视频数据集(除 NextQA 和感知测试以外),我们评估了 2023 年 11 月仍公开可用的视频。

Gemini Ultra 在各种少示例视频字幕任务以及零示例视频问答任务上均实现了最先进的成绩,如表 10 所示。这证明了它在多帧上具有强大的时间推理能力。附录中的图 21 提供了一个定性示例,展示了理解足球运动员的击球技巧视频,并推理出运动员如何提高其比赛技能。

表 10 | Gemini 模型在选定学术基准上的少示例视频理解跨任务和语言表现。报告的指标包括视频字幕的 CIDER,NextQA 的 WUPS,以及感知测试和 ActivityNet-QA 的前 1 准确率。对于 ActivityNet-QA,我们采用了 Video-LLAVA(Lin 等人,2023)的评估协议。

5.2.3. 图像生成

Gemini 能够直接输出图像,无需依赖中间的自然语言描述,这种描述可能会限制模型表达图像的能力。这使得模型能够在少示例设置中响应包含图像和文本的序列提示,以生成图像。例如,用户可能会提示模型为博客文章或网站设计图像和文本建议(参见附录中的图 10)。

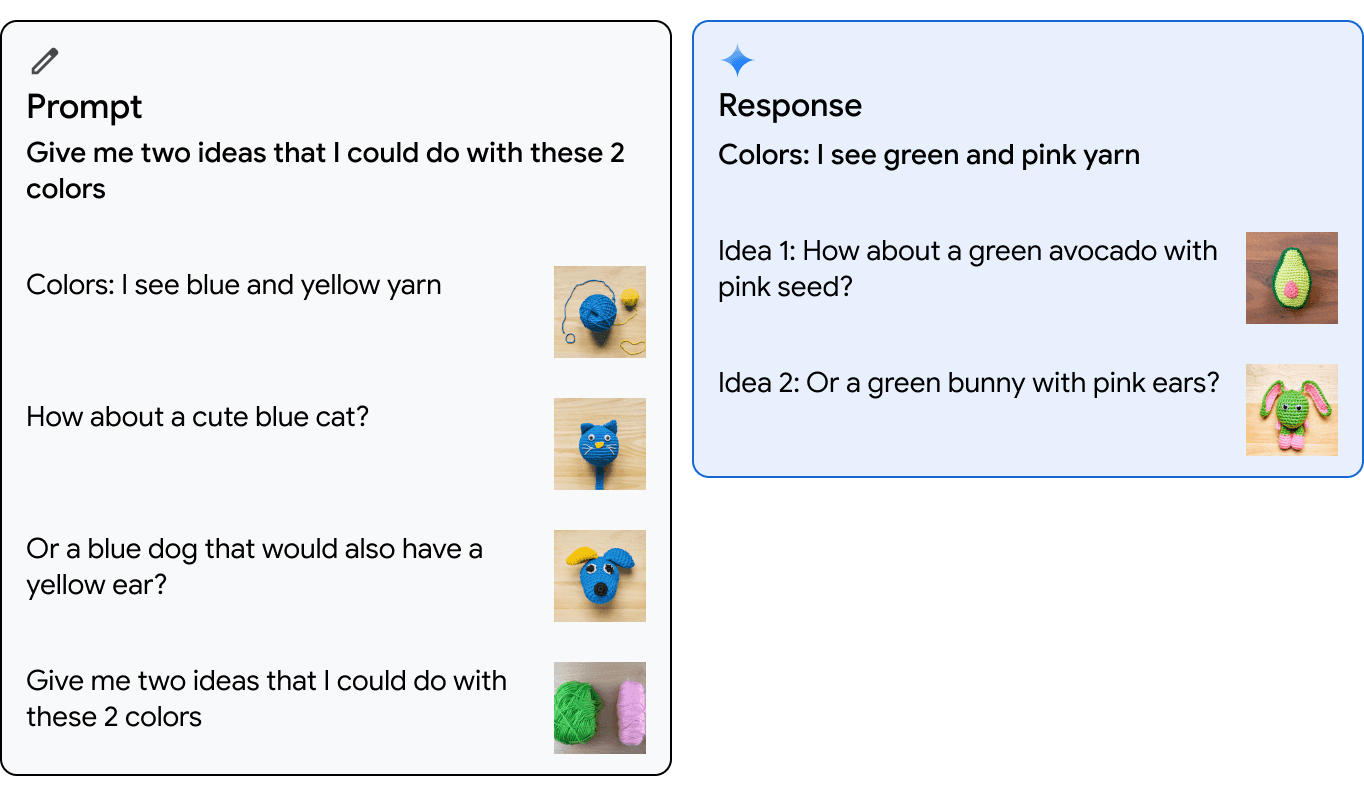

图 6 展示了一个单示例设置中的图像生成示例。Gemini Ultra 模型被提示提供两种颜色(蓝色和黄色)以及创建蓝色猫或带黄色耳朵的蓝狗的图像建议。接着,模型被给予两种新颜色(粉色和绿色),并被要求提供使用这些颜色的创意建议。模型成功地生成了图像和文本交织的序列,提出了使用这些颜色制作可爱的绿色鳄梨和粉色种子或绿色兔子和粉色耳朵的创意建议。

图 6 | 图像生成示例。在这个单示例设置中,Gemini 能够同时输出多张图像并与文本交织在一起。在左侧图片中,Gemini Ultra 根据用户的提示生成了使用蓝色和黄色创建可爱猫咪和狗狗的创意建议。随后,模型接收到两种新颜色——粉色和绿色的提示,并生成了创意建议,包括制作可爱的绿色鳄梨和粉色种子或绿色兔子和粉色耳朵,如右侧图片所示。

5.2.4. 音频理解

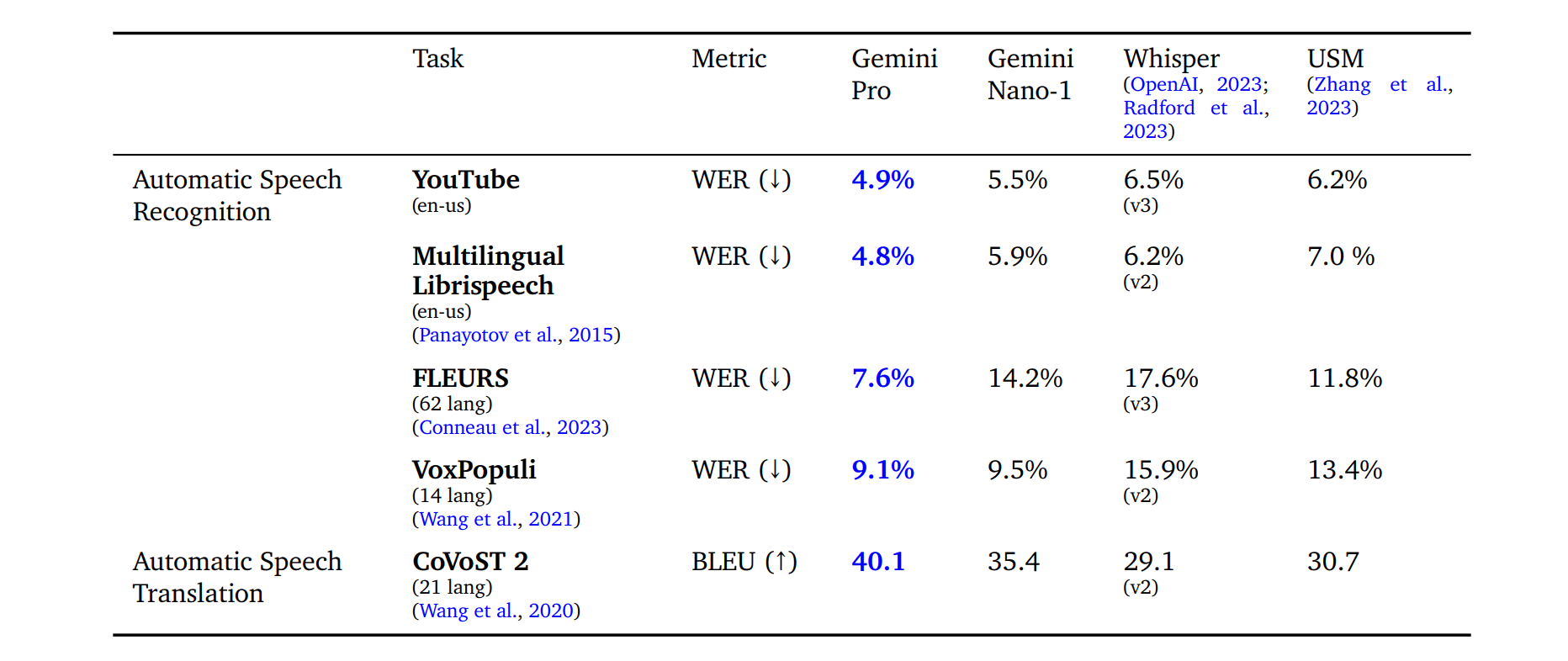

我们在一系列公开的基准测试中评估了 Gemini Nano-1 和 Gemini Pro 模型,并将其与通用语音模型(USM)(Zhang 等人,2023)和 Whisper(large-v2(Radford 等人,2023)或 large-v3(OpenAI,2023))进行了对比。这些基准测试包括自动语音识别(ASR)任务,如 FLEURS(Conneau 等人,2023),VoxPopuli(Wang 等人,2021),多语言 Librispeech(Panayotov 等人,2015),以及将不同语言翻译成英语的语音翻译任务 CoVoST 2(Wang 等人,2020)。我们还对一个内部基准的 YouTube 测试集进行了评估。ASR 任务的评估标准是字错误率(WER),数字越低越好。翻译任务的评估标准是双语评估替代(BLEU)得分,数字越高越好。FLEURS 的评估报告了与训练数据重叠的 62 种语言。四种分段语言(普通话、日语、韩语和泰语)的评估是字符错误率(CER),而不是 WER,类似于 Whisper(Radford 等人,2023)。

表 11 显示,我们的 Gemini Pro 模型在所有 ASR 和 AST 任务上均显著优于 USM 和 Whisper 模型,无论是对英语还是多语言测试集。值得注意的是,与 USM 和 Whisper 相比,Gemini Pro 在 FLEURS 基准上取得了巨大的提升,因为我们的模型也使用了 FLEURS 训练数据集。然而,即使不使用 FLEURS 数据集,同一模型的 WER 为 15.8,仍优于 Whisper。Gemini Nano-1 模型在除 FLEURS 之外的所有数据集上也表现优于 USM 和 Whisper。值得一提的是,我们尚未对 Gemini Ultra 进行音频评估,但预期随着模型规模的增大,其性能会进一步提升。

表 11 | Gemini 模型在特定基准测试上的语音理解评估结果,涵盖 ASR 和 AST 任务。ASR 任务的评估指标是字错误率(WER),越低表示性能越好。AST 任务的评估指标是双语评估替代(BLEU)得分,得分越高表示性能越好。

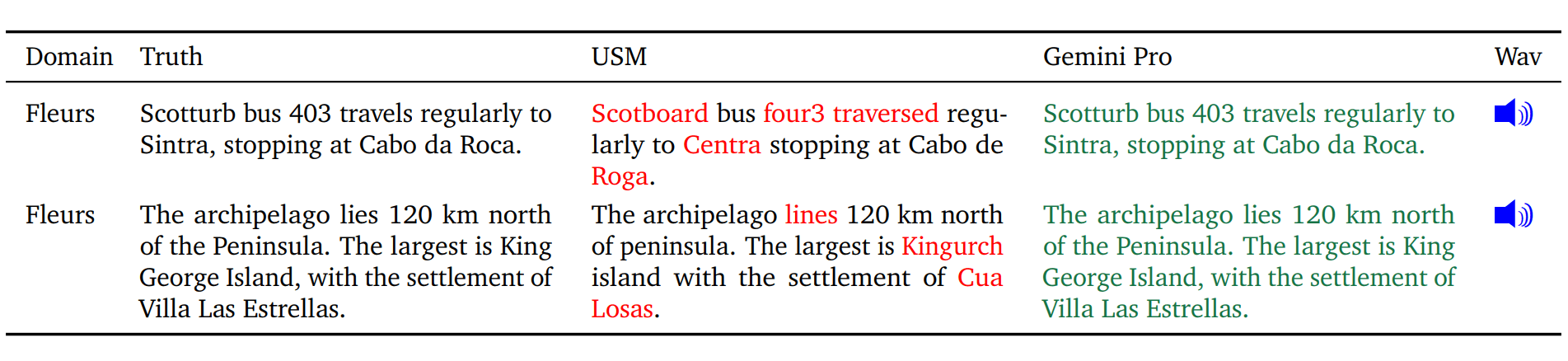

表 12 提供了对 USM 和 Gemini Pro 的进一步错误分析。我们注意到,Gemini Pro 生成的响应更容易理解,尤其是在处理罕见词汇和专有名词方面表现出色。

- Wav:

- https://storage.googleapis.com/deepmind-media/gemini/fleurs1.wav

- https://storage.googleapis.com/deepmind-media/gemini/fleurs2.wav

表 12 | 在基准测试中 ASR 任务的定性示例。错误转录部分以红色突出显示。

5.2.5. 模态组合

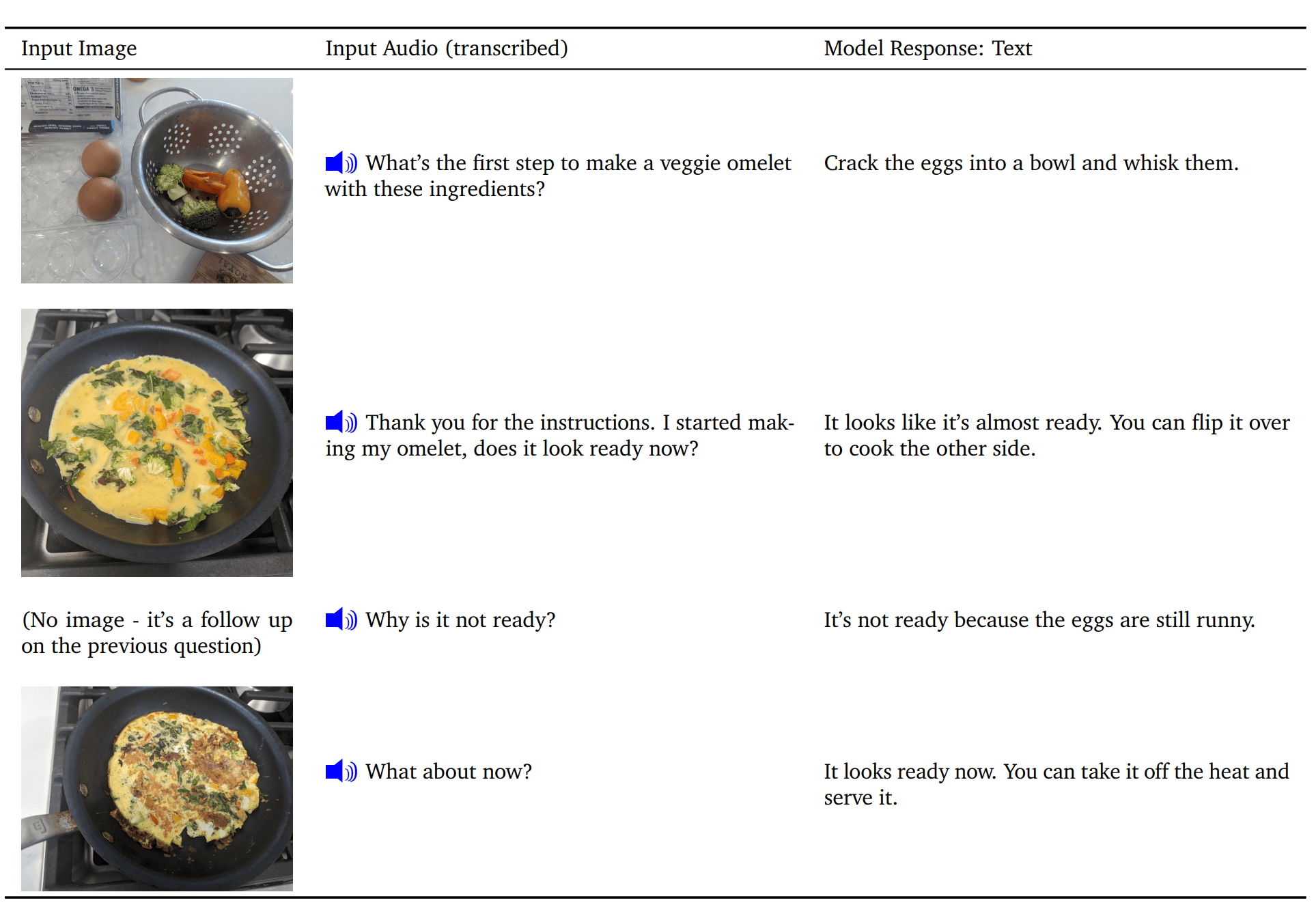

多模态演示通常涉及将文本与单一模态(通常为图像)结合的序列。我们展示了模型处理音频和图像序列的能力。

以制作煎蛋卷的烹饪场景为例,我们通过音频和图像序列向模型提出提示。表 13 展示了与模型的逐步互动,提供图片并口头提问有关制作煎蛋卷的下一步操作。我们注意到模型的响应文本相当准确,并且能够处理图像细节来判断煎蛋卷是否煮熟。请访问我们的网站查看此演示。

- Wav:

- https://storage.googleapis.com/deepmind-media/gemini/gemini_av_input_1.wav

- https://storage.googleapis.com/deepmind-media/gemini/gemini_av_input_2.wav

- https://storage.googleapis.com/deepmind-media/gemini/gemini_av_input_3.wav

- https://storage.googleapis.com/deepmind-media/gemini/gemini_av_input_4.wav

表 13 | 音视频交互定性示例。该示例展示了 Gemini 模型处理交织在一起的文本、视觉和音频序列以及跨模态推理的能力。示例中的烹饪场景中,用户提示模型提供制作煎蛋卷的步骤指导,并检查煎蛋卷是否煮熟,涵盖了涉及图片和关于制作煎蛋卷下一步操作的口头问题的逐回合互动。

6. 负责任部署

在 Gemini 模型的开发过程中,我们采用了一种结构化方法来负责任地部署,目的是识别、衡量和管理我们模型可能产生的预见社会影响,这与谷歌此前发布的 AI 技术的做法保持一致(Kavukcuoglu 等人,2022)。在整个项目的生命周期中,我们遵循以下结构。本节将概述我们在此过程中采用的整体方法和主要发现。我们将在即将发布的报告中分享更多细节。

6.1. 影响评估

我们制定了模型影响评估,目的是识别、评估和记录与开发先进 Gemini 模型相关的关键社会利益和潜在风险。这些评估基于先前关于语言模型风险的学术文献(Weidinger 等人,2021),以及行业内类似先前练习的发现(Anil 等人,2023;Anthropic,2023;OpenAI,2023a),持续与内外部专家的接触,以及对新模型漏洞的非结构化尝试。我们关注的领域包括:真实性、儿童安全、有害内容、网络安全、生物风险、代表性和包容性。这些评估随模型开发的进展而同步更新。

影响评估用于指导缓解措施和产品交付工作,并为部署决策提供信息。Gemini 影响评估涵盖了 Gemini 模型的不同能力,评估了这些能力与谷歌 AI 原则(Google,2023)的潜在后果。

6.2. 模型政策

在理解已知和预期影响后,我们制定了一系列“模型政策”,旨在引导模型的开发和评估。这些模型政策定义作为负责任开发的标准化标准和优先级框架,同时也是衡量发布准备情况的标志。Gemini 模型政策涵盖了众多领域,包括儿童安全、仇恨言论、事实准确性、公平与包容性以及骚扰等。

6.3. 评估

为了根据模型政策领域和影响评估中识别的其他关键风险领域对 Gemini 模型进行评估,我们开发了一整套覆盖模型开发全周期的评估方法。

开发评估旨在模型训练和微调阶段进行,以实现模型性能的逐步提升。这些评估由 Gemini 团队设计,或针对外部学术基准进行。评估内容包括帮助性(如指令遵循和创造力)、安全性和事实性等方面。有关具体结果的示例,请参见第 5.1.6 节和下一节中关于缓解措施的讨论。

保证评估是出于治理和审查目的,在关键里程碑或训练运行结束时由模型开发团队之外的团队执行。保证评估采用模态化的标准,严格独立的数据集。仅将关键见解反馈给训练过程,以帮助缓解工作。保证评估包括针对 Gemini 政策的测试,并持续检测潜在的生物危害、说服能力和网络安全等风险能力(Shevlane 等人,2023)。

外部评估由谷歌以外的合作伙伴执行,旨在发现盲点。外部团队对我们的模型进行了一系列问题的压力测试,包括白宫承诺书⁷中列出的领域,测试既包括结构化评估,也包括非结构化红队行动。这些评估的设计是独立的,结果定期向谷歌 DeepMind 团队报告。

除了上述外部评估套件之外,我们的专业内部团队还对模型进行持续的红队行动,涵盖 Gemini 政策和安全等领域。这些活动包括更少结构化的过程,涉及复杂的对抗性攻击,用于发现新的漏洞。发现的潜在弱点可以用于缓解风险,并改进内部评估方法。我们致力于保持模型的持续透明度,并计划逐步公开我们的评估套件的更多结果。

6.4. 缓解措施

这些缓解措施是针对上述评估、政策和评估方法的结果而开发的。评估和缓解以迭代方式进行,随着缓解工作的进展,评估将被重复进行。以下我们将讨论我们在数据、指令调整和事实性方面减少模型危害的努力。

6.4.1. 数据

在训练前,我们采取了多项措施,以在数据策划和数据收集阶段减少潜在的下游风险。正如“训练数据”部分所述,我们过滤了训练数据中的高风险内容,确保所有训练数据质量高。除了过滤,我们还采取了措施确保收集的所有数据符合 Google DeepMind 的数据丰富化最佳实践⁸,这些实践基于 AI 合作伙伴关于“负责任采集数据丰富化服务”的指南⁹。其中包括确保所有数据丰富化工作者获得至少等同于当地生活工资的报酬。

6.4.2. 指令调整

指令调整包括监督式微调(SFT)和通过人类反馈的强化学习(RLHF),使用奖励模型。我们在文本和多模态设置中应用了指令调整。指令调整配方经过精心设计,以平衡提高帮助性和减少模型危害,如安全性和幻觉(Bai 等人,2022a)。

在监督式微调(SFT)、奖励模型训练和通过人类反馈的强化学习(RLHF)中,“质量”数据的策划至关重要。通过较小模型对数据混合比例进行测试,以平衡有用性(例如指令遵循、创造力)和减少模型危害的指标,这些结果对更大模型同样适用。我们还发现,相比于数量,数据质量更为重要(Touvron 等人,2023b;Zhou 等人,2023),特别是对于更大的模型。对于奖励模型训练,我们发现平衡数据集中模型倾向于说“我无法帮助”(出于安全原因)和输出有帮助响应的例子非常关键。我们采用多目标优化方法,利用有益性、事实性和安全性的奖励得分加权总和来训练一个多头奖励模型。

我们进一步详细介绍了我们如何缓解危险文本生成的问题。我们识别了大约 20 种危害类型(如仇恨言论、提供医疗建议、推荐危险行为),这些类型涵盖了广泛的用例。我们通过政策专家和机器学习工程师手动创建潜在危险查询的数据集,或者使用关键词作为种子来提示高能力语言模型。

在面对危害诱导的查询时,我们对我们的 Gemini 模型进行了探测,并通过两两评估来分析模型的响应。正如之前所述,我们在模型输出响应无害与有帮助之间寻找平衡。从识别的风险领域中,我们创建了额外的监督式微调数据,以展示理想的响应。为了大规模生成这些响应,我们广泛依赖于一个自定义数据生成配方,该配方的灵感来自宪法式人工智能(Bai 等人,2022b),在其中我们将谷歌内容政策的变体作为“宪法”,并利用语言模型的强大零示例推理能力(Kojima 等人,2022)来修正响应,并在多个响应候选中进行选择。我们发现这个配方非常有效 - 例如,在 Gemini Pro 中,这整个配方能够缓解我们识别的大多数文本危害案例,而不会对响应的有用性造成明显降低。

6.4.3. 事实性

对我们的模型而言,在各种场景中生成准确且事实上正确的响应非常重要,同时也要减少产生幻觉的情况。我们将指令调整工作集中在三个关键期望行为上,这些行为反映了现实世界的场景:

- 归因:若指示要求生成的响应完全基于提示中给出的上下文,Gemini 应产生最忠实于上下文的响应(Rashkin 等人,2023)。这包括用户提供的来源摘要、根据问题和给定片段生成精确引用(类似于 Menick 等人,2022;Peng 等人,2023)、回答基于长篇文本(如书籍)的问题,以及将给定的来源转换为所需输出(例如,根据会议记录部分生成电子邮件)。

- 闭卷响应生成:如果提出一个寻求事实的提示,而没有给定任何来源,Gemini 不应产生错误的幻觉信息(参见 Roberts 等人(2020)对闭卷的定义)。这些提示可能包括寻求信息的提示(例如,“谁是印度的总理?”)或可能请求事实信息的半创造性提示(例如,“写一篇 500 字的支持采用可再生能源的演讲”)。

- 规避:如果给出的输入提示是“无法回答的”,Gemini 不应产生幻觉。相反,它应该通过规避来表示无法提供答案。这包括输入提示包含错误前提问题(参见 Hu 等人(2023)的例子)、输入提示要求模型执行开卷问答,但答案并非基于给定上下文的场景。

我们通过策划专门的监督式微调数据集和进行 RLHF 来促进 Gemini 模型展现这些期望行为。值得注意的是,这里的结果并未包含使 Gemini 获得额外工具或检索能力的端到端结果,据说这能提高事实性(Menick 等人,2022;Peng 等人,2023)。以下是我们在各个挑战集上的三个关键结果。

- 事实性测试集:这个测试集包含寻求事实的提示(主要是闭卷类型)。通过人类评审员手动核查每个响应的事实性来评估;我们报告了被评审员判断为事实不准确的响应百分比。

- 归因测试集:这个测试集包含了需要归因于提示中来源的各类提示。通过人类评审员手动检查每个响应的归因性来评估;报告的指标是 AIS(Rashkin 等人,2023)。

- 规避测试集:在自动化评估设置中,我们测量了 Gemini 模型是否准确地执行规避。

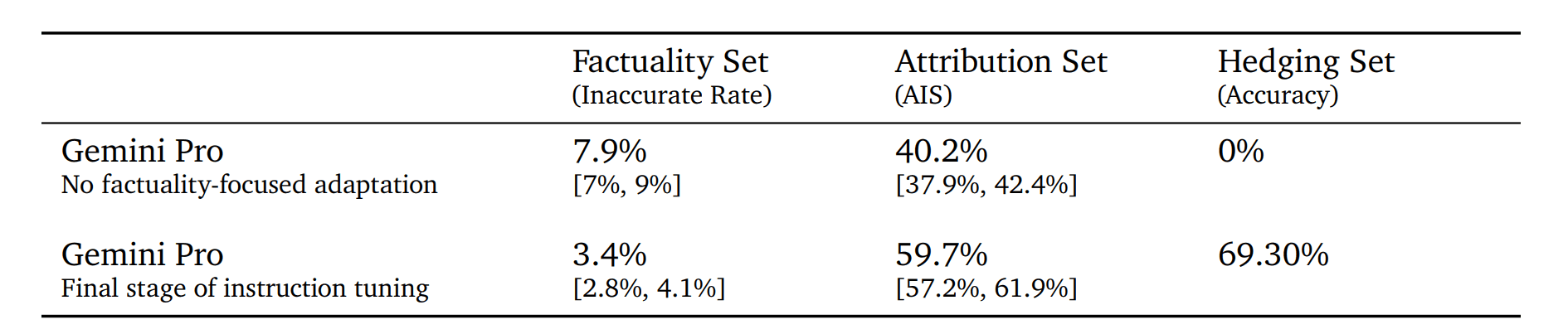

我们比较了 Gemini Pro 与未针对事实性进行特别适应的指令调整版 Gemini Pro 模型,如表 14 所示。我们发现,事实性测试集中的不准确率减少了一半,在归因测试集中的归因准确率提高了 50%,在提供的规避测试集任务中,成功规避的比率从 0% 提高到了 70%。

表 14 | 提高事实性的缓解措施成效:指令调整对事实不准确率、归因准确率和正确规避率的影响(包括相应的 95% 置信区间)。

6.5. 部署实施

在完成审查之后,我们为每个通过审查的 Gemini 模型创建了模型卡,以结构化且一致的方式记录关键的性能和责任指标,以及为了向外界传达这些指标而随时间更新的信息。

6.6. 负责任的治理

在负责任的开发过程中,我们与谷歌 DeepMind 的责任与安全委员会(RSC)¹⁰进行了一系列伦理和安全审查。RSC 是一个跨学科小组,负责评估谷歌 DeepMind 的项目、论文和合作是否符合谷歌的 AI 原则。RSC 对影响评估、政策制定、评估和缓解措施提供了重要的输入和反馈。在 Gemini 项目期间,RSC 为关键政策领域(例如儿童安全)设定了具体的评估目标。

7. 讨论与结论

我们介绍了 Gemini,这是一系列新模型,它们推动了多模态模型在文本、代码、图像、音频和视频方面的能力发展。本技术报告评估了 Gemini 在广泛研究的一系列基准上的表现,我们最强大的模型 Gemini Ultra 在所有领域都取得了显著进步。在自然语言领域,由于数据和模型训练规模方面的深入发展,性能提升持续带来质量改进,为多个基准设置了新的最高标准。特别是 Gemini Ultra 在考试基准 MMLU 上超过了人类专家的表现,得分为 90.0%,自 2020 年该基准首次发布以来,它一直是衡量 LLM 进步的重要标准。在多模态领域,Gemini Ultra 在大多数图像理解、视频理解和音频理解基准上设定了新的标准,而且这些成就是在未进行特定修改或调整的情况下实现的。特别值得注意的是,Gemini Ultra 在最近发布的 MMMU 基准(Yue 等人,2023)上展现了卓越的多模态推理能力,这个基准涵盖了需要大学水平科目知识和深入推理的图像问题。

除了在基准测试上的最先进的表现之外,我们对 Gemini 模型能够开启的新用例感到非常兴奋。Gemini 模型解析复杂图像(如图表或信息图)的新能力,对图像、音频和文本交织序列进行推理的能力,以及生成交织文本和图像作为响应的能力,为各种新应用打开了大门。如报告和附录中的图表所示,Gemini 可能会在教育、日常问题解决、多语言交流、信息总结、提取和创造力等领域带来全新的方法。我们相信,使用这些模型的用户将会发掘出超出我们在自身研究中仅初步探索到的种种有益应用。

虽然这些模型能力惊人,但我们也必须认识到大型语言模型(LLMs)使用上的局限性。关于大型语言模型产生的“幻觉”现象,仍需持续研究和开发工作,以确保模型输出更加可靠和可验证。此外,尽管在考试类基准测试中表现出色,大型语言模型在处理需要高阶推理能力的任务时仍面临挑战,比如因果理解、逻辑推导和反事实推理。这凸显了进行更具挑战性和稳健性的评估的必要性,以真实衡量它们的理解能力,特别是在当前最先进的大型语言模型已在许多基准测试中达到性能饱和的情况下。

Gemini 是我们实现解决智能、推进科学和造福人类使命的又一步。我们期待看到谷歌和其他同事如何使用这些模型。我们在本报告中介绍的模型建立在机器学习、数据、基础设施和负责任开发方面的诸多创新之上——这些领域是我们在谷歌十多年来一直在追求的。我们介绍的模型为我们更广泛的未来目标提供了坚实的基础,即开发一个具有跨多模态广泛泛化能力的大规模、模块化系统。

参考文献

本译文略去参考文献,详细的参考文献请参阅PDF版本。

8. 贡献和致谢

本译文略去贡献者列表,详细的贡献者列表请参阅PDF版本。

以下是各种角色的定义:

- 负责人 (Lead):个人或团队在整个项目期间负责子团队。

- 核心贡献者 (Core Contributor):在整个项目期间产生重大影响的个人。

- 贡献者 (Contributor):对项目有贡献并部分参与努力的个人。

- 项目负责人 (Program Lead):负责协调 Gemini 项目的组织工作。

- 总技术负责人 (Overall Technical Lead):负责指导整个 Gemini 项目的技术方向。

在每个角色中,贡献是平等的,并以随机顺序列出。每个角色内部的排列顺序不表示贡献的顺序。

Gemini 是一个跨谷歌的合作项目,涵盖来自 Google DeepMind (GDM)、Google Research (GR)、知识与信息 (K&I)、核心 ML、云、实验室等部门的成员。

我们感谢我们的审稿人和同事,对报告的宝贵讨论和反馈表示感激 — 包括 Alexandra Belias、Arielle Bier、Eleanor Tomlinson、Elspeth White、Emily Hossellman、Gaby Pearl、Helen King、Hollie Dobson、Jaclyn Konzelmann、Jason Gelman、Jennifer Beroshi、Joel Moss、Jon Small、Jonathan Fildes、Oli Gaymond、Priya Jhakra、Rebecca Bland、Reena Jana 和 Tom Lue。

我们的工作得以实现,要感谢谷歌众多团队的奉献和努力。我们要感谢 Abhi Mohan, Adekunle Bello, Aishwarya Nagarajan, Alejandro Lince, Alexander Chen, Alexander Kolbasov, Alexander Schiffhauer, Amar Subramanya, Ameya Shringi, Amin Vahdat, Anda Rabatić, Anthonie Gross, Antoine Yang, Anthony Green, Anton Ruddock, Art Khurshudov, Artemis Chen, Arthur Argenson, Avinatan Hassidim, Beiye Liu, Bin Ni, Brett Daw, Bryan Chiang, Burak Gokturk, Carey Radebaugh, Carl Crous, Carrie Grimes Bostock, Charbel Kaed, Charlotte Banks, Che Diaz, Chris Larkin, Christy Lian, Claire Cui, Clement Farabet, Daniel Herndon, Dave Burke, David Battle, David Engel, Dipannita Shaw, Donghyun Koo, Doug Ritchie, Dragos Stefanescu, Emre Sargin, Eric Herren, Estella King, Fatema Alkhanaizi, Fernando Pereira, Gabriel Carvajal, Gaurav Gandhi, Goran Pavičić, Harry Richardson, Hassan Wassel, Hongji Li, Igor Ivanisevic, Ivan Jambrešić, Ivan Jurin, Jade Fowler, Jay Yagnik, Jeff Seibert, Jenna LaPlante, Jessica Austin Jianxing Lu, Jin Huang, Jonathan Caton, Josh Woodward, Joshua Foster, Katrina Wong, Kelvin Nguyen, Kira Yin, Konstantin Sharlaimov, Kun Li, Lee Hong, Lilly Taylor, Longfei Shen, Luc Mercier, Mania Abdi, Manuel Sanchez, Mario Carlos Cortes III, Mehdi Ghissassi, Micah Mosley, Michael Bendersky, Michael Harris, Mihir Paradkar, Nandita Dukkipati, Nathan Carter, Nathan Watson, Nikhil Dandekar, Nishant Ranka, Obaid Sarvana, Olcan Sercinoglu, Olivier Lacombe, Pranesh Srinivasan, Praveen Kumar, Rahul Sukthankar, Raia Hadsell, Rajagopal Ananthanarayanan, Roberto Lupi, Rosie Zou, Sachin Menezes, Sadegh Jazayeri, Sameer Bidichandani, Sania Alex, Sanjiv Kumar, Sarah Fitzgerald, Sebastian Nowozin, Shannon Hepburn, Shayne Cardwell, Sissie Hsiao, Srinivasan Venkatachary, Sugato Basu, Sundar Pichai, Sundeep Tirumalareddy, Susannah Young, Swetha Vijayaraghavan, Tania Bedrax-Weiss, Terry Chen, Ting Liu, Tom Cobley, Tomas Izo, Trystan Upstill, Varun Singhai, Vedrana Klarić Trupčević, Victor Cai, Vladimir Pudovkin, Vu Dang, Wenbo Zhao, Wesley Crow, Wesley Szeng, Xiaodan Song, Yazhou Zu, Ye Tian, Yicong Wang, Yixing Wang, Zachary Jessup, Zhenchuan Pang, Zimeng Yang, and Zoubin Ghahramani. We'd also like to recognize the AlphaCode team, the Borg Scheduling team, the Facilities team, the Gemini Demo Team, the Global Server Ops (GSO) team, the JAX team, the the Legal team, ML SRE team, the ML Supercomputer (MLSC) team, the PartIR team, the Platforms Infrastructure Engineering (PIE) team, and the XLA Compiler team,.

还要感谢在谷歌工作的所有人,虽然没有在上述名单中明确提到,他们分享了激情,提供了早期 Gemini 模型的反馈,创建了有趣的 Gemini 演示用途,以及在项目的许多方面与核心 Gemini 团队合作或支持。

9. 附录

9.1. 在 MMLU 基准上的思维链方法比较

在本节中,我们比较了多种在 MMLU 基准测试上的思维链方法,并对其结果进行了讨论。我们提出了一种新策略,即模型生成多个(k 个)思维链样本,并在模型足够自信时采用多数投票法,否则则选择最优样本。这些阈值根据模型在验证集上的表现进行优化。我们将这种方法称为“不确定性引导思维链”。这种方法的基本思路是,当模型明显表现出不一致性时,相比于最大似然法,使用思维链样本可能会降低性能。我们在图 7 中展示了这种新方法在 Gemini Ultra 和 GPT-4 上的效果对比。结果显示,Gemini Ultra 从该方法中获益更显著,尤其是相较于单纯使用思维链样本。GPT-4 的性能已从单一样本的 84.2% 提升至使用 32 个样本的不确定性引导思维链方法后的 87.3%,但其在使用 32 个思维链样本时已实现这一提升。相比之下,Gemini Ultra 的性能从单一样本的 84.0% 显著提升至使用 32 个样本的不确定性引导思维链方法后的 90.0%,而单纯使用 32 个思维链样本时,其性能提升较为有限,仅达到 85.0%。

图 7 | 在 MMLU 上应用不确定性路由的思维链方法。

9.2. 能力与基准测试任务

我们采用了 50 多个基准测试作为全面评估工具,以此来衡量 Gemini 模型在文本、图像、音频和视频方面的各项能力。我们为文本理解和生成领域的六大能力——事实核查、长篇文本处理、数学/科学、推理、摘要和多语言处理——提供了详尽的基准测试任务列表。同时,我们还列出了用于评估图像理解、视频理解和音频理解能力的相关基准测试。

- 事实性检验:我们采用了 5 个基准测试,包括 BoolQ(Clark 等,2019),NaturalQuestions-Closed(Kwiatkowski 等,2019),NaturalQuestions-Retrieved(Kwiatkowski 等,2019),RealtimeQA(Kasai 等,2022)以及 TydiQA-noContext 和 TydiQA-goldP(Clark 等,2020)。

- 长篇文本理解:我们使用了 6 个基准测试,包括 NarrativeQA(Kočiský 等,2018),Scrolls-Qasper,Scrolls-Quality(Shaham 等,2022),XLsum(英文),XLSum(非英文语种)(Hasan 等,2021),以及一个其他的内部基准测试。

- 数学/科学理解:我们使用了 8 个基准测试,包括 GSM8k(结合 CoT)(Cobbe 等,2021),Hendryck 的 MATH pass@1(Hendrycks 等,2021b),MMLU(Hendrycks 等,2021a),Math-StackExchange,Math-AMC 2022-2023 问题,以及另外三个内部基准测试。

- 逻辑推理:我们使用了 7 个基准测试,包括 BigBench Hard(结合 CoT)(Srivastava 等,2022),CLRS(Veličković 等,2022),Proof Writer(Tafjord 等,2020),Reasoning-Fermi 问题(Kalyan 等,2021),Lambada(Paperno 等,2016),HellaSwag(Zellers 等,2019),DROP(Dua 等,2019)。

- 文本总结:我们使用了 5 个基准测试,包括 XL Sum(英文),XL Sum(非英文语种)(Hasan 等,2021),WikiLingua(非英文语种),WikiLingua(英文)(Ladhak 等,2020),XSum(Narayan 等,2018)。

- 多语种处理:我们使用了 10 个基准测试,包括 XLSum(非英文语种)(Hasan 等,2021),WMT22(Kocmi 等,2022),WMT23(Tom 等,2023),FRMT(Riley 等,2023),WikiLingua(非英文语种)(Ladhak 等,2020),TydiQA(无上下文),TydiQA(GoldP)(Clark 等,2020),MGSM(Shi 等,2023),翻译版 MMLU(Hendrycks 等,2021a),NTREX(Federmann 等,2022),FLORES-200(团队等,2022)。

- 图像与视频理解:我们用于图像理解的 9 个基准测试包括 MMMU(Yue 等,2023),TextVQA(Singh 等,2019),DocVQA(Mathew 等,2021),ChartQA(Masry 等,2022),InfographicVQA(Mathew 等,2022),MathVista(Lu 等,2023),AI2D(Kembhavi 等,2016),VQAv2(Goyal 等,2017)和 XM3600(Thapliyal 等,2022),后者用于多语言图像理解。此外,我们还使用了 6 个视频理解基准测试,包括 VATEX(Wang 等,2019),用于两种不同语言的视频字幕,YouCook2(Zhou 等,2018),NextQA(Xiao 等,2021),ActivityNet-QA(Yu 等,2019)和感知测试 MCQA(Pătrăucean 等,2023)。

- 音频处理:我们采用了 5 个基准测试来评估音频处理能力,包括自动语音识别(ASR)任务,如 FLEURS(Conneau 等,2023),VoxPopuli(Wang 等,2021),多语言 Librispeech(Panayotov 等,2015),以及自动语音翻译任务,例如 CoVoST 2(Wang 等,2020)。

9.3. 定性实例展示

本节将展示提示 Gemini Ultra 模型后得到的一些定性实际案例。图 8、9、11、13、14 和 15 展示了包括图表、自然图像和梗图在内的多模态推理在图像理解任务中的应用。图 10 则展示了 Gemini Ultra 在图像生成方面的能力,用户在此创建了包含图文交织的博客文章。此外,图 16 展示了该模型在多语言环境中理解图像的能力。在数学领域,Gemini 模型同样在多模态图像理解和推理上表现出色,如图 12、18 和 19 所示。图 20 是一个展示模型如何结合复杂的图像理解、代码生成和遵循用户指令能力的复杂多模态推理示例。在图 17 中,我们看到模型能够根据复杂的用户指令生成有效代码的另一实例。最后,图 21 展示了 Gemini Ultra 在理解视频方面的能力,通过对一系列时间上相连的帧进行分析和推理。

9.3.1. 图表理解与数据分析

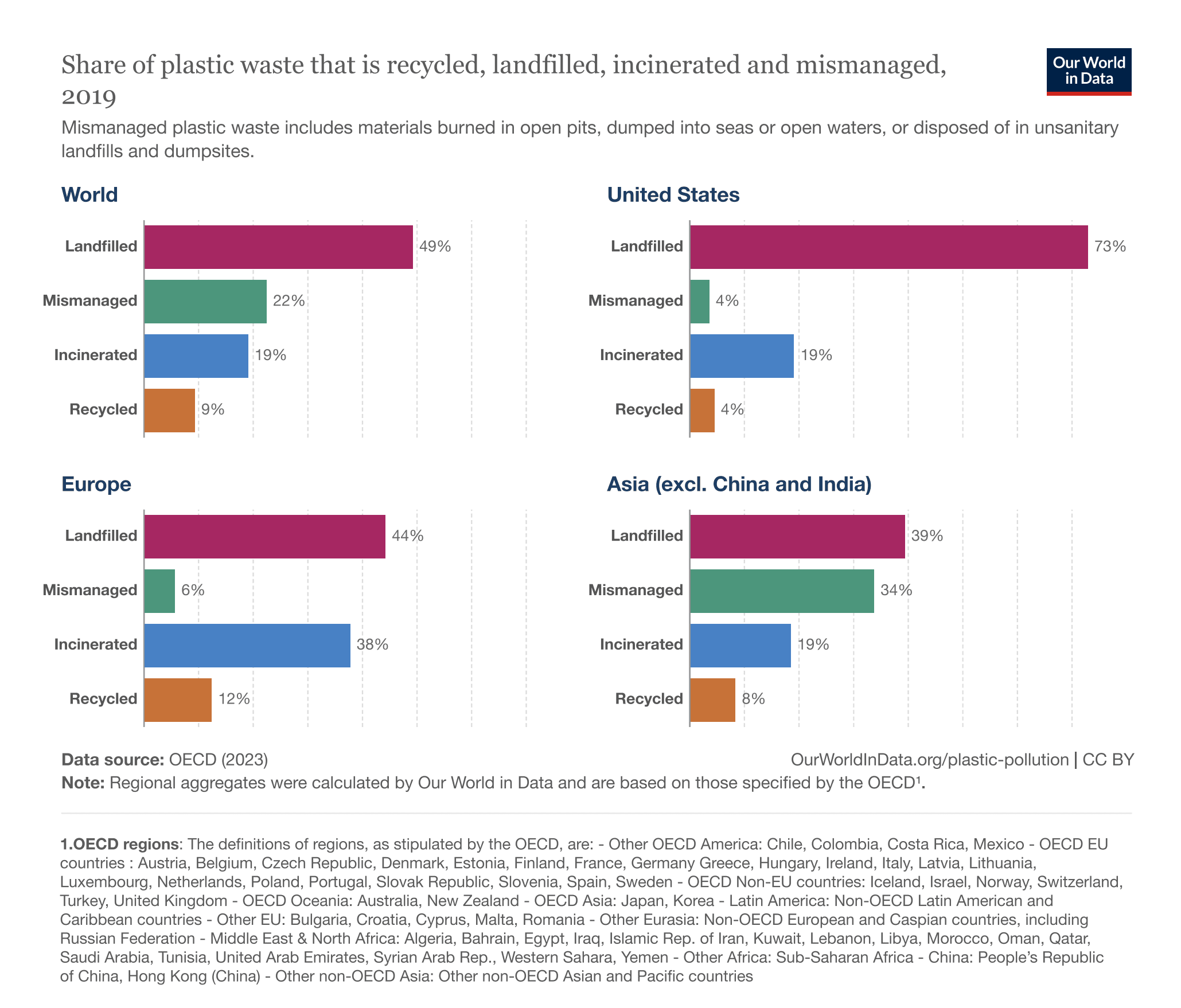

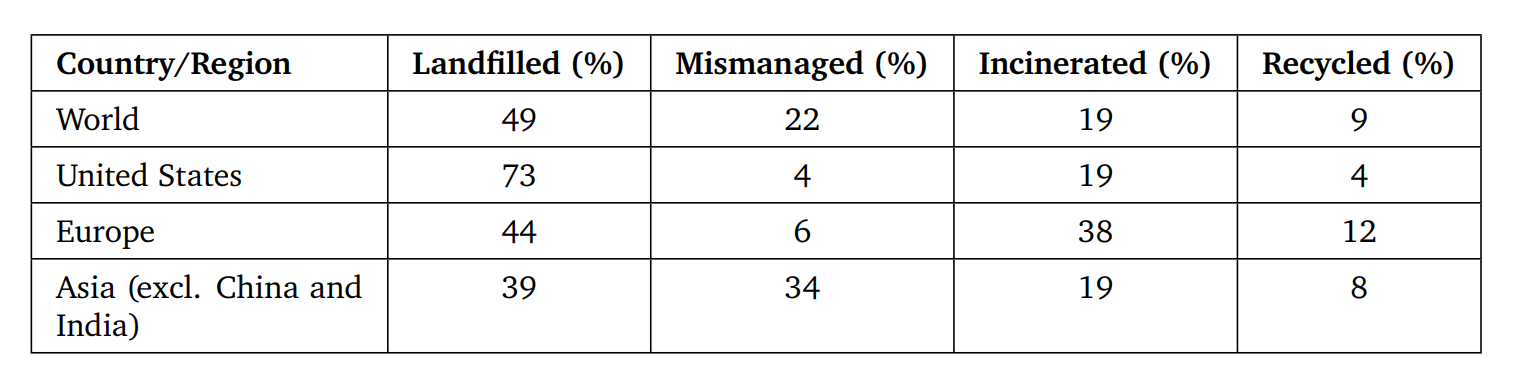

提示词

在这些图表中找出一个显著的数据点及其潜在含义。然后,为所展示的所有数据制作一个详尽的 markdown 表格。

模型响应(Markdown 渲染后)

最显著的数据点是美国的填埋塑料废物比例,达到了 73%。这比展示的其他国家和地区要高得多。这表明美国在回收或焚烧塑料废物方面的工作相比其他国家和地区来说做得较少。

图 8 | 解决需要多模态图表理解的问题。模型需要阅读并理解文本,挖掘不同数据点之间的联系,并据此进行推理,以找出一个引人注目的数据点,并按指示生成一个 markdown 表格(如图所示正确渲染)。

来源:Our World In Data(Ritchie 等人,2023)。

9.3.2. 多模态问答

提示词

你知道这它什么植物吗?我该怎样才能更好地照顾它?

模型回答

这是一株波斯盾植物。它是原产于东南亚的热带植物,因其易于护理和美丽的紫色叶片而成为受欢迎的室内植物。

波斯盾植物偏好明亮而间接的光照。它们能够忍受一定程度的直射阳光,但过多的直射阳光可能会灼伤叶片。它们还喜欢温暖和高湿度的环境。

波斯盾植物需要定期浇水,但不能让它们长时间浸泡在水中。土壤应保持湿润但不过分湿泽。定期喷水也对它们有益。

在生长季节,波斯盾植物每两周施一次肥。使用平衡型肥料是个不错的选择。

波斯盾植物容易受到如粉虱和蜘蛛螨等害虫侵害。可以使用杀虫皂或植物油来防治这些害虫。

波斯盾植物可以通过茎段扦插进行繁殖。扦插应在春季或夏季进行,并应在水中或湿润的盆栽介质中生根。

图 9 | 回答多模态信息查询请求。模型能够识别图像中展示的特定植物,并提供关于它的信息。模型展示了对拼写错误的鲁棒性,因为它能够理解用户问题,尽管其中存在拼写错误。

来源:由 Gemini 团队成员拍摄。

9.3.3. 生成图文并茂内容

提示词

请创作一篇关于去纽约旅行的博客文章,讲述一只狗和它的主人如何度过一段快乐时光。请包含几张这只狗在不同名胜地开心摆拍的照片。

模型回答

嗨,我是 Cooper。我是一只两岁的金毛贵宾犬,对旅行充满热情。上个月,我和家人一起去了纽约市。这是我第一次造访这座大苹果城市,我玩得非常开心!

我们住在时代广场附近的酒店。那些明亮的灯光和熙熙攘攘的人群真是太棒了。我们还去看了一场百老汇秀,并且我还有幸见到了一些演员。

纽约市我最喜欢的地方之一是中央公园。它既大又美丽。我喜欢在那儿奔跑,玩接球游戏。我们还参观了自由女神像和帝国大厦。能看到这些著名的地标真是太令人兴奋了。

我在纽约市的体验非常棒。这无疑是我最喜爱的旅行目的地之一。我迫不及待想再次造访!

图 10 | 生成图文并茂内容。该模型能够根据指令创作出与文本内容紧密相关的博客文章,并且在所有图片中保持了狗的形象一致性。

9.3.4. 图形理解与推理

提示词

观察这一系列三个形状。按这个顺序,下一个形状应该是什么?请详细描述前面的形状,并说明你的推理逻辑。

模型回答

下一个形状应该是六边形。第一个形状是三角形,第二个是正方形,第三个是五边形。每个形状的边数依次增加。

图 11 | 解决一项多模态推理难题。模型成功识别了图中的形状,并理解了它们的特性,凭借这些信息推测出它们之间的逻辑关系,从而预测出下一个形状。

来源:由 Gemini 团队成员拍摄。

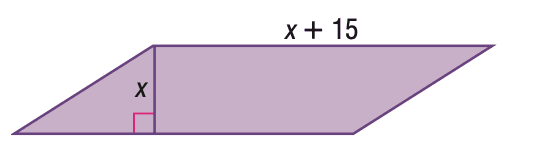

9.3.5. 几何形状的推理解析

提示词

求出给定面积为 100 平方单位的平行四边形的高度。

模型回答

平行四边形的面积等于其底边长度和高的乘积。因此,100 = (𝑥 + 15)𝑥。我们解得 𝑥² + 15𝑥 − 100 = 0。该方程的解为 𝑥₁ = 5 和 𝑥₂ = −20。第二个解是负数,不符合实际情况。因此,最终答案是 5。希望这个答案是正确的。

图 12 | 应对几何形状的推理挑战。尽管问题描述略显含糊,但模型展示了对问题的准确理解,并提供了合理的推理过程。

来源: Lu 等人. (2021).

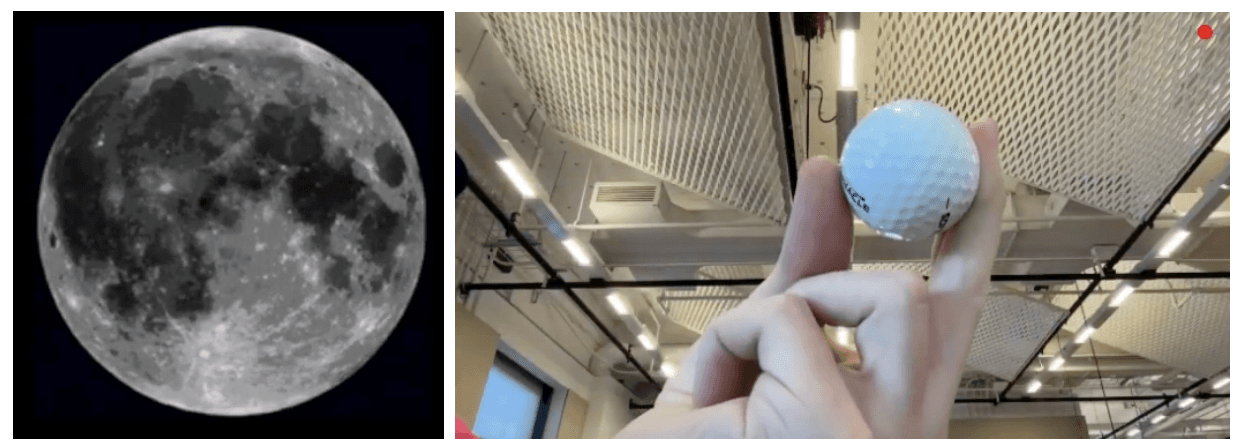

9.3.6. 物体信息的寻找

提示词

找出这些图像之间的联系。提示:思考与历史事件有关的内容。

模型回答

月球是唯一一个人类进行过高尔夫球击球活动的天体。1971年,阿波罗14号任务中的宇航员在月球表面打了两球高尔夫。

图 13 | 利用多模态输入解答谜题。模型成功识别出图像中的物体,并找到了它们之间的联系。

来源:由 Gemini 团队成员拍摄。

9.3.7. 基于视觉线索的多模态推理

提示词

你能辨认出这张照片是在哪里拍摄的吗?

模型回答

前景中的街道是第八大道,而交叉的街道是西 34 街。

图 14 | 即使在图像略有视觉扭曲的情况下,也能识别图像中的物体(帝国大厦)。基于图像,模型还能准确地判断出拍照者所在的具体位置。

来源:由 Gemini 团队成员拍摄。

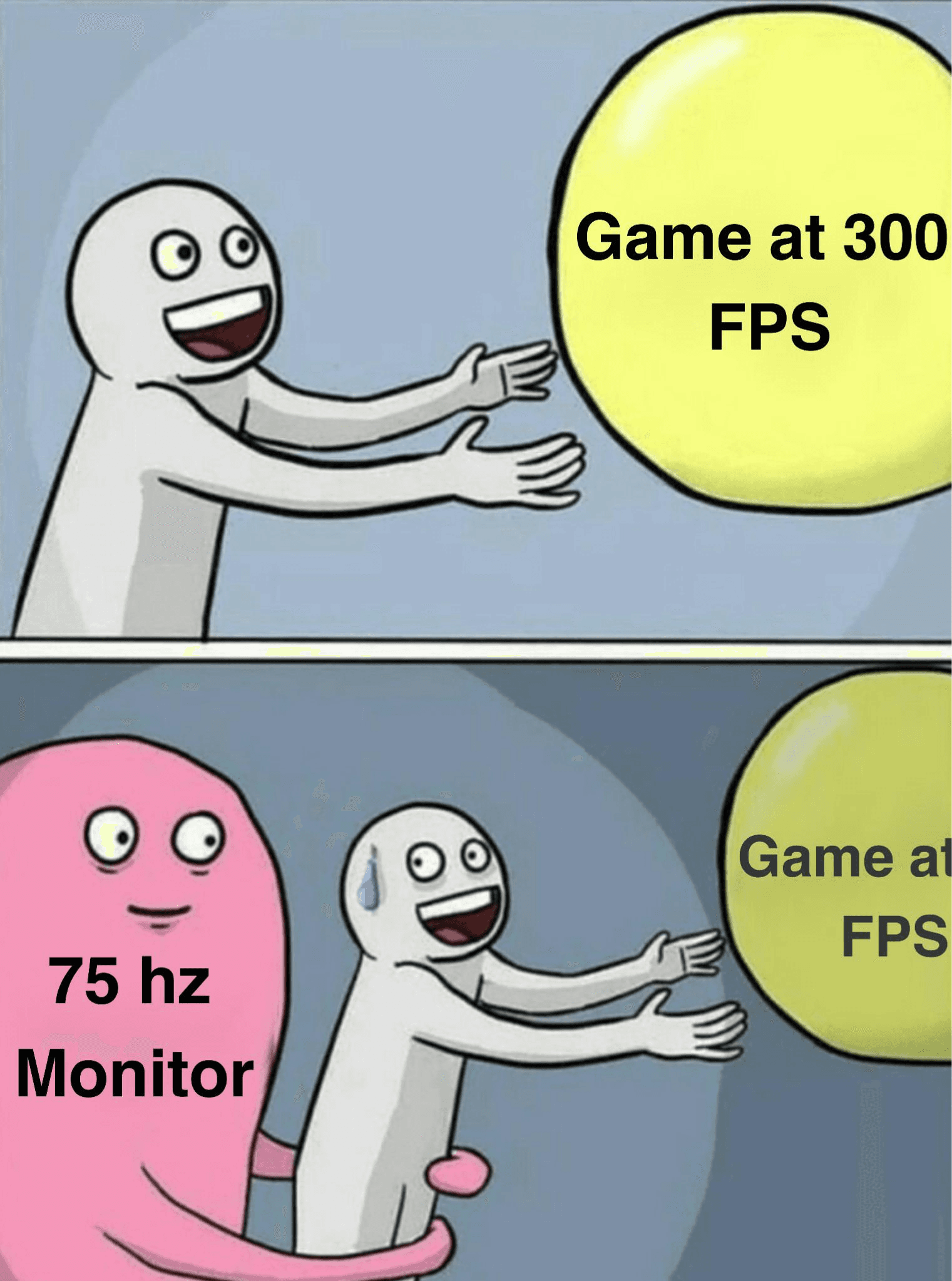

9.3.8. 解读多模态幽默

提示词

你能解释这个梗图的含义吗?

模型回答

这个梗图讲的是一个人在 300 FPS(每秒帧数)的情况下玩游戏,但他的显示器只有 75Hz 的刷新率。他在努力追上游戏的速度,但游戏的速度太快,超出了他的显示器显示能力。这个梗图之所以引人发笑,是因为它触及了那些曾在显示器跟不上游戏速度时玩游戏的人的共鸣。

图 15 | 对梗图中的幽默进行解释。模型不仅描述了图像中的情景,还阐释了其含义,尽管这些文化背景并未在图像或提示词中直接说明。

来源:Hwang 和 Shwartz(2023)。

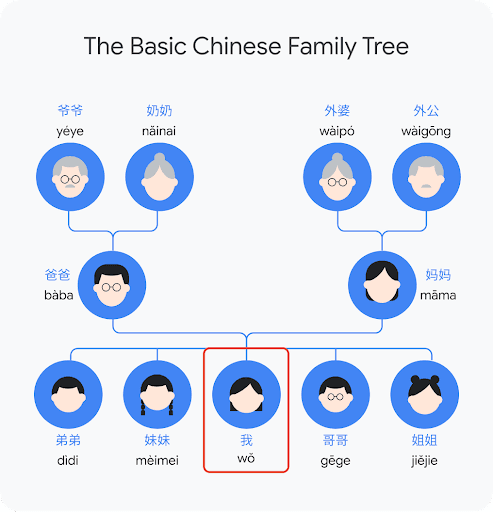

9.4. 多语种背景下的常识性推理

提示词

依据这幅图表,解释我应该如何称呼我父母双方的祖父母。

模型回答

在你父亲这边,你可以称呼你的祖父母为爷爷(Yéye)和奶奶(Nˇainai)。在你母亲这边,则称呼为外公(Wàig¯ong)和外婆(Wàipó)。

图 16 | 图中的常识性推理。模型成功解读了图表所表达的家族关系,并能在多语种背景下进行准确的推理。

来源:由 Gemini 团队成员制作的图像。

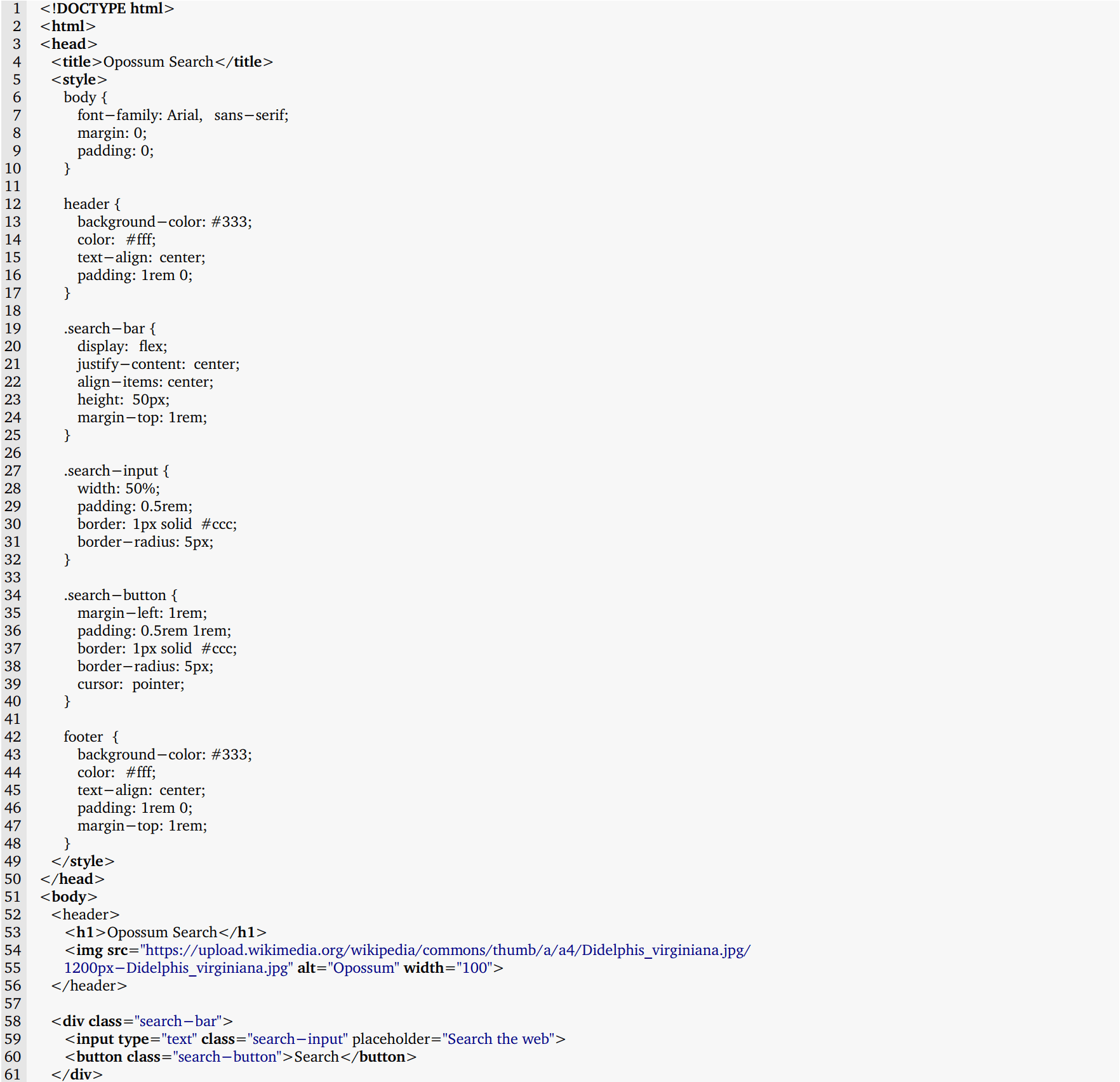

9.4.1. 逻辑推理与代码生成

提示词

创建一个名为“Opossum Search”的网页应用:

- 当你进行搜索查询时,它应该重定向你到一个带有相同查询词的谷歌搜索页面,但在查询词前加上“opossum”一词。

- 界面上要与谷歌搜索相似,

- 替换谷歌的标志,使用网上的一张负鼠图片。

- 它应该是单一的 html 文件,无需额外的 js 或 css 文件。

- 页脚应注明“由谷歌搜索提供支持”。

模型回答(代码渲染后)

这是 Opossum Search 的代码:

这段代码生成了一个视觉上类似于谷歌搜索的简洁网页应用,但以负鼠图像作为标志。输入搜索词并点击“搜索”按钮后,它会将你重定向到一个在查询词前加上“opossum”的谷歌搜索页面。应用的页脚标注“由谷歌搜索提供支持”。

渲染后的网站

图 17 | 根据用户需求编写网站代码。模型准确遵从用户提出的指令和要求,成功转化为实际可用的代码。

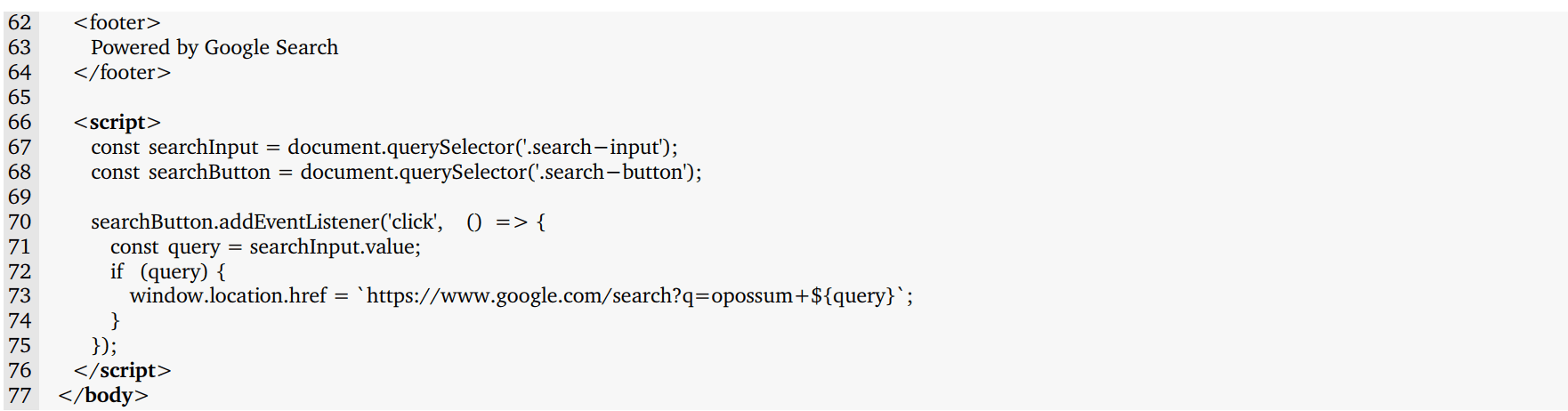

9.4.2. 数学领域:微积分挑战

提示词

求解 sinh 𝑥 + cosh 𝑦 = 𝑥 + 𝑦 的导数。

模型回答(LaTex 渲染后)

图 18 | 应对微积分挑战。模型不仅成功解答了微积分问题,还提供了详细的逐步解析和正确格式的 LaTeX 方程。

来源:Macmillan Learning 提出的问题。

9.5. 多步骤推理与数学解答

提示词

在 2018 年,A 工厂生产了价值 5 亿福林的商品,而 B 工厂生产了价值 4 亿福林的商品。根据他们的长期计划,A 工厂每年将增加 5% 的产量,而 B 工厂将每年增加 6% 的产量。

这项计划发布在一个经济类网站上。在文章的评论区,一场辩论随之展开:一位用户认为,未来几年两家工厂之间的产量差将逐渐缩小。

请计算下表中缺失的数值,并证明上述观点是错误的。

表头: | 2018 | 2019 | 2020 | 2021 |

A 工厂生产量(百万) | 500 | | | |

B 工厂生产量(百万) | 400 | | | |

模型回答(Markdown 渲染后)

| 年份 | A 工厂生产量(百万) | B 工厂生产量(百万) | 差异(百万) |

|---|---|---|---|

| 2018 | 500 | 400 | 100 |

| 2019 | 525 | 424 | 101 |

| 2020 | 551.25 | 449.44 | 101.81 |

| 2021 | 578.81 | 476.41 | 102.4 |

A 工厂 2019 年的生产量是 500 * 1.05 = 525 百万福林。

B 工厂 2019 年的生产量是 400 * 1.06 = 424 百万福林。

2019 年两个工厂的生产量差异是 525 - 424 = 101 百万福林。

A 工厂 2020 年的生产量是 525 * 1.05 = 551.25 百万福林。

B 工厂 2020 年的生产量是 424 * 1.06 = 449.44 百万福林。

2020 年两个工厂的生产量差异是 551.25 - 449.44 = 101.81 百万福林。

A 工厂 2021 年的生产量是 551.25 * 1.05 = 578.81 百万福林。

B 工厂 2021 年的生产量是 449.44 * 1.06 = 476.41 百万福林。

2021 年两个工厂的生产量差异是 578.81 - 476.41 = 102.4 百万福林。

从这些数据可以明显看出,两家工厂之间的生产量差异并没有减少,而是在增加。因此,认为未来几年两家工厂之间的生产量差异会逐渐缩小的观点是错误的。

图 19 | 解决多步数学问题。模型不仅理解了问题的本质,还成功生成了一个准确计算数值的 markdown 表格。此外,它还详细说明了数值的来源,并直接回答了问题中提出的疑问。

来源:Oktatási Hivatal(2023,第 20 页)。

9.5.1. 复杂图像理解、代码生成与指令执行

提示词

请将左上角子图所示函数乘以 1000,再加到左下角子图所示函数上。生成 matplotlib 代码来得到的这个单一图表。

模型回答(代码渲染后)

图表渲染后

图 20 | 应用多模态推理能力于代码生成。Gemini Ultra 需要完成逆向图形分析任务来推测出生成这些图表的代码,进行必要的数学处理,并生成相应的代码。

来源:由 Gemini 团队成员制作的图像。

9.5.2. 视频内容理解与分析

提示词(视频)

这位运动员应该如何提升他们的技巧?

模型回答

这位足球运动员需要提升他们的射门技巧。他们与球的接触不够理想,这导致球偏离了目标方向。他们还需要优化身体姿势。在射门时,他们应该让非踢球腿靠前,并确保踢球腿能够有效跟进。

图 21 | 对视频内容进行理解并对视频情景进行分析推理。这里我们向模型提供了一个视频及其文本提示词(此处的图像仅用于展示)。模型能够分析视频中的动作,并提出如何改善视频中展示的技巧。

视频来源:“Football/Soccer Penalty Miss” https://www.youtube.com/watch?v=VmWxjmJ3mvs

¹: 有关完整作者名单,请参阅贡献与致谢部分。相关咨询请发邮件至 [email protected]。

²: 我们打算在 Gemini Ultra 模型正式推出前更新此报告,提供更多详细信息。

³: 我们定义有效输出为在整个培训过程中用于完成有用新步骤的时间。

⁴: 请访问 https://deepmind.google/gemini 查看相关演示。

⁵: http://codeforces.com/

⁶: MathVista 是一个全面的数学推理基准,包含了 28 个已发布的多模态数据集和三个新创建的数据集。我们的 MathVista 结果是通过运行其作者的评估脚本得到的。

⁷: https://whitehouse.gov/wp-content/uploads/2023/07/Ensuring-Safe-Secure-and-Trustworthy-AI.pdf

⁸: https://deepmind.google/discover/blog/best-practices-for-data-enrichment/

⁹: https://partnershiponai.org/responsible-sourcing-considerations/

¹⁰: https://deepmind.google/about/responsibility-safety/

© 2023 谷歌。版权所有